Les processus géologiques de surface et dépôts associés

Transcription

Dans le cadre des enjeux du programme Géo SIS, l'un concerne les formations de surface. Hélène Tissoux, bonjour.

-Bonjour. Vous êtes chercheuse à la Direction des géoressources et vous nous présentez vos travaux sur les processus géologiques de surface. Mais avant cela, pouvez-vous nous expliquer ce qu'est une formation de surface ?

-Tout à fait. Les formations de surface, il y en a de 2 sortes. Il y a les formations d'altération qui sont des altérations, donc, au sommet des roches qui sont au contact de l'atmosphère et des circulations d'eau. Et puis, il y a tous les sédiments. Les sédiments transportés par les cours d'eau, par les glaciers, par le vent, par la mer, et des sédiments tels que les sables des rivières ou les limons cultivés en Beauce. Ça peut être les galets sur les plages ou les éboulis en montagne. Donc, ces sédiments, on les voit sur l'illustration. Ils ont été mis en place par différents agents, la glace, la gravité, le vent, l'eau... Il y a aussi un profil d'altération représenté en bas à droite. Donc, ces formations de surface, on les retrouve sur une grande partie du territoire. Et leur présence, leur nature et leur répartition sont complètement liées à des processus externes, à des facteurs externes tels que le climat, les cycles glaciaires, interglaciaires ou la tectonique, mais pas de type séisme. Je parle là des orogènes qui permettent la création des reliefs.

-Des orogènes ? Les orogènes, la création des reliefs montagneux. Ou alors la subsidence qui, elle, permet l'enfoncement et la création des bassins, le comblement des bassins, tel le bassin de la Sologne. Donc, ces formations, notamment sédimentaires, ont en général moins de 3 millions d'années. Ce qui est très récent, la Terre en ayant, elle, plus de 4 milliards. Mais elles sont très importantes, car l'on vit dessus. Ce sont elles que nous exploitons. On l'a vu pour la ressource en eau. Et ce sont celles sur lesquelles l'on construit nos infrastructures. Ça peut être une ligne de TGV, un pont ou une autoroute. Donc, le travail du géologue de surface va être d'étudier ces formations de surface, mais aussi les processus qui sont à l'origine de leur présence. Et pourquoi est-ce important de les étudier ? Je vais répondre par des questions. Pourquoi la Loire qui coulait sous nos pieds il y a 400 000 ans a migré de plusieurs kilomètres vers le nord ? Sous quelles contraintes ? Et quel était leur poids par le passé ? Quel est-il aujourd'hui et quel sera-t-il demain ? Si on arrive à comprendre comment ces formations de surface ont été mises en place, comment elles ont évolué sous les différents processus et les contraintes qu'il y a derrière, on sera mieux à même de prévoir comment ces formations pourront se comporter dans le futur, notamment dans le cadre du changement global. Que se passera-t-il si on augmente les précipitations, les événements extrêmes, si on modifie le couvert forestier, si on modifie le niveau marin ? Donc, pour mieux comprendre ces processus. Tout à fait. Et c'est mieux les comprendre pour mieux les représenter. L'idée, derrière, c'est de pouvoir produire des cartes, des cartes qui seront utilisées par nous, bien sûr, au BRGM, mais également par nos étudiants, par les académiques, par les collectivités territoriales ou par des exploitants de ressources minérales.

-Mais des cartes, il y en a toujours eu. Quelle est la pertinence de continuer à en faire ? Oui, on a aujourd'hui une couverture quasi complète du territoire en cartographie géologique. Ce sont les célèbres cartes géologiques au 50 millième. Il y a près de 1 100 coupures qui couvrent le territoire métropolitain. Et on a aussi les cartes qui sont bien connues, qui sont les cartes départementales harmonisées, la Bd Charm. Ces cartes reprennent la connaissance géologique qui est sur les coupures 50 000, mais les harmonisent et les représentent sur l'emprise d'un département. Mais le constat... Il y a 2 constats qui ont été faits. Le 1er, c'est qu'on se rend compte que pour les usages et les besoins actuels, l'échelle du 50 millième n'est pas toujours suffisante, pas toujours adaptée. Et l'autre constat, c'est que... Et il a été fait depuis longtemps. C'est qu'il y a de grosses lacunes de connaissance sur les formations de surface sur ces cartes-là. Des grosses lacunes et surtout de grosses hétérogénéités, notamment sur les cartes les plus anciennes. Car il y a 50 ou 60 ans, les préoccupations étaient tout autres. Et on cherchait plutôt les ressources qui étaient dans le substratum profond. On ne voyait pas l'intérêt de représenter ces formations de surface qui étaient souvent pelliculaires, hétérogènes, complexes et qui en plus masquaient ce que l'on voulait vraiment voir. Donc, il y a un vrai manque de connaissance qu'aujourd'hui on cherche à combler. Et donc, un gros investissement pour ces connaissances-là. Quelles avancées récentes dans ce domaine ? Les avancées récentes... Enfin, l'idée des projets que l'on mène actuellement, c'est d'utiliser notre connaissance des processus pour aider à pouvoir proposer une cartographie prédictive, à pouvoir prédire la probabilité de présence de ces formations de surface. Là où on n'a pas la connaissance. L'avantage de travailler sur la surface, c'est justement que les formations sont à la surface et que donc, on peut les voir, et qu'elles ont une forme associée dans le paysage. Et on sait que souvent, à un processus, on peut associer une forme. Donc, le travail que l'on essaye de faire, c'est d'utiliser cette forme dans le paysage, cette morphologie, pour essayer de prévoir la présence de ces formations de surface.

-Vous avez un exemple ?

-Oui. Voilà à l'écran un exemple du travail que l'on a fait pour la 1re fois en 2020 sur le granit. Le granit, il y en a dans le Massif central, en Bretagne, dans les Vosges. Et comme on le voit à gauche de l'écran, le granit, quand il est soumis à des conditions externes, à de l'altération, il va commencer par se fissurer. Puis, il va s'altérer de plus en plus. On va finir par avoir des boules de granit au sein d'une matrice beaucoup plus altérée. Tout ça prend énormément de temps. On est sur une échelle de l'ordre du million d'années. Et puis, ces boules vont finir par s'altérer complètement.

-Et le produit final sera un sable...

-Qu'on voit là à l'image.

-On voit le processus.

-Tout à fait. Et ce qu'il faut savoir, c'est que ce sable-là n'a plus du tout ni les compétences... Enfin... Oui, compétences physiques ou chimiques, ou les caractéristiques du granit. Or, sur la carte géologique, c'est bien le granit qui est représenté. Donc, nous, on va utiliser ces différents degrés d'altération et leur réponse dans le paysage pour essayer d'estimer leur présence. Bon, on imagine bien qu'un granit sur le terrain peut prendre une pente très forte et on va pouvoir le trouver sous forme de falaise. Une fois devenu sable, le sable n'a plus la cohésion pour qu'on le retrouve sous forme de falaise. Il sera plutôt sur les surfaces très peu pentées ou planes. Donc, l'idée qu'on a eue, c'est d'associer pour chaque degré d'altération, une pente que l'on va trouver dans le paysage. Alors, on travaille sur un modèle numérique de terrain. Et on va associer à chaque degré d'altération une classe de pente que l'on peut trouver sur le paysage. Donc, lorsque l'on représente ça en cartographie, voilà ce que ça donne. Sur la carte qui est en haut à gauche en rose, ce sont les granits tels qu'ils sont cartographiés actuellement. En bas à droite, voilà ce qu'on obtient lorsque l'on met en place ce processus nouveau. On se rend compte que tout ce qu'il y a en orange, c'est ce qui a des pentes faibles et que l'on a associé à des arènes granitiques. Donc, tout ce qui est en orange sur cette carte est très probablement couvert non pas de granit, mais de sable.

-Oui, ça change tout.

-Voilà. On est bien sûr sur une carte prédictive qui doit être validée par des retours sur le terrain. C'est une aide. Mais néanmoins, en termes effectivement d'impacts, par exemple, pour la géotechnique, c'est énorme. Là, on voit bien qu'il y a une véritable évolution entre l'avant, l'après. À quoi ça va servir concrètement ? Bon, là, je présente des résultats qui sont très préliminaires. Ce sont des travaux effectués dans le cadre d'un projet exploratoire du BRGM, qui a débuté l'an dernier. Ce 1er test est fait sur les granits... du Massif central. On prévoit, bien sûr, de tester dans différents contextes tant géologiques que régionaux. Et puis, également de travailler sur d'autres types de formes et d'autres processus géologiques pour avoir un panel un peu plus complet. Mais l'idée, à terme, c'est bien de proposer des cartes nouvelles. Et ces cartes seront, comme on a pu le voir, des cartes en lithologie. C'est-à-dire qu'elles nous donneront une indication sur la nature de la surface. Est-ce que c'est un sable, une argile, une marne ? Voilà. Et surtout directement utilisables ou transposables pour les usages. On pourra facilement utiliser ces données pour améliorer les cartes de retrait-gonflement des argiles, pour améliorer les cartes de risques sismiques, notamment ce qu'on appelle le microzonage sismique, pour des aides à la décision tant au BRGM que pour des utilisateurs externes. Donc, pour tout ce qui concerne les géosciences au sens large. De multiples applications. Merci beaucoup.

Applications des méthodes électromagnétiques aux risques naturels

Transcription

Nous accueillons à distance... Bonjour, Aude Nachbaur.

-Bonjour.

-Vous nous entendez bien ?

-Oui.

-Et nous avons sur le plateau Mathieu Darnet. Bonjour à vous 2. Donc, Aude Nachbaur, vous êtes chercheuse à la Direction des actions territoriales. Et vous, Mathieu Darnet, chercheur à la Direction des risques et prévention. Et dans le cadre de la gestion des risques, précisément, vous développez une nouvelle méthode géophysique électromagnétique. Pouvez-vous nous expliquer ce que c'est ? Oui, tout à fait. Je pense qu'il y a pas mal de choses qui ont déjà été dites sur la géophysique jusqu'à présent par les précédents intervenants. Nous, le focus, ici, il est sur les méthodes électromagnétiques. C'est une méthode géophysique parmi toutes celles qui peuvent exister. Technique qui a été développée au BRGM depuis de nombreuses années. Ce qu'il faut retenir dans le cas de l'application aux risques naturels, c'est qu'on développe des techniques spécifiques à ces risques naturels, soit sur les méthodes d'acquisition, de traitement ou d'imagerie de ces données. En l'occurrence, ces dernières années, nous avons beaucoup travaillé sur les méthodes héliportées. Vous voyez à l'écran une petite représentation d'artiste de ce que cela implique. Donc, dans ces méthodes héliportées, les capteurs et les récepteurs géophysiques sont tractés par des moyens aériens, en l'occurrence, sur l'image, un hélicoptère. L'autre type de méthode qui a été fortement développée ces dernières années, c'est la magnétotellurie pour des applications à haut risque. Donc, celle-là, c'est une méthode différente. Elle est déployée sur le sol avec des capteurs qui mesurent les variations du champ électromagnétique terrestre. Ces 2 méthodes permettent de cartographier le sous-sol. Et ce qu'on a appris, c'est notre façon de développer des algorithmes et d'interpréter ces données pour caractériser de meilleure façon différents aléas, notamment les aléas volcaniques, de glissement de terrain ou sismiques. Et quels résultats on obtient ? Alors, les résultats... Déjà, ce qui est important de savoir, c'est que ces méthodes électromagnétiques permettent de caractériser une propriété physique du sol qui est la conductivité électrique des roches. Alors, pourquoi s'intéresse-t-on à ce paramètre ? C'est assez simple, la conductivité électrique des roches traduit finalement la facilité des roches à conduire le courant électrique. Et comme vous le savez bien, l'eau, l'eau minéralisée plus particulièrement, conduit très bien le courant. Ce paramètre est intéressant à mesurer pour nous donner une indication sur la nature, la quantité, le degré de minéralisation des fluides présents dans le sol. Un autre paramètre qui fait évoluer la conductivité électrique, c'est aussi la présence d'argile ou de produits d'altération de type argileux. Et donc, ces 2 paramètres mesurés de manière conjointe nous permettent d'évaluer la nature des roches du sous-sol, de déterminer la présence de fluides, autre paramètre intéressant, et comme on a ces deux 1ers paramètres statiques, d'évaluer les propriétés dynamiques, voir si ces fluides évoluent dans le temps. Donc, la caractérisation du sous-sol par cette conductivité électrique, c'est ce qui est fait avec ces méthodes héliportées pour restituer une carte en 3 dimensions du sous-sol et de la conductivité électrique en particulier. Dans le cas de la magnétotellurie, on suit l'évolution de cette productivité électrique et notamment, on essaye de voir si on peut voir des variations de fluides hydrothermaux et / ou magmatiques dans le cas de l'évaluation de l'aléa volcanique. D'accord. Et est-ce qu'on peut avoir un exemple sur le territoire de la collecte de ces mesures et pertinent par rapport à ces risques, justement, naturels ? Je vais laisser Aude répondre. Oui. Ben, par exemple, je pourrais évoquer effectivement les territoires d'outre-mer qui sont particulièrement exposés à un certain nombre de risques naturels et pour lesquels les données électromagnétiques évoquées par Mathieu apportent beaucoup d'informations. Les risques qui sont en proche surface, glissement de terrain, liquéfaction des sols, érosion, mais également tout ce qui est en plus grande profondeur. Et pertinent effectivement aussi le mode d'acquisition, puisque les données nouvelles qui nous sont données par ces mesures sont aussi sur un large territoire et nous donnent accès à une information homogène, qui est vraiment adaptée à la gestion des risques pour hiérarchiser les zones sensibles sur une île. Donc, les mesures géophysiques qui restent très importantes pouvaient être déployées sur les zones à enjeux ou sur des zones à projet d'aménagement. Mais là, avec cette couverture du territoire, grâce à l'héliporté, toutes les communes bénéficient de la même information. Et on peut espérer des résultats prometteurs ? Oui, alors, il y a beaucoup de projets qui exploitent ces données parce qu'elles renseignent sur la nature des roches. Je voudrais évoquer les glissements de terrain et l'anticipation qu'elles pourraient nous donner sur les menaces de grand glissement, de glissement profond. Jusqu'alors, les cartes d'aléas traitaient cet aspect-là, mais difficilement, puisqu'en fait, on parle d'horizons qui sont sous la surface à 10, 20, 30 m de profondeur et qui, donc, sont difficilement perceptibles par le géotechnicien sans mettre en place des mesures coûteuses et très lourdes. Donc... Et qui pourtant posent des problèmes énormes sur l'aménagement du territoire. La chance qu'on a, c'est que les horizons plastiques, ceux qui vont se déformer de manière irréversible et qui vont causer ces gros glissements de terrain, correspondent aux parties les plus altérées de nos roches volcaniques. Et comme elles sont particulièrement chargées d'argile, elles vont être plus facilement repérées sur les données de conductivité. Donc, le projet, par exemple, MVT Mar, qui a actuellement lieu en Martinique... exploite ces données de conductivité, ainsi que des données de géologie. Il y a un levé fait par les géologues sur les formations de surface, donc, le régolithe, pour permettre d'identifier a priori ces zones où il y a des horizons suspects pour des grands glissements et préciser ainsi la menace à l'échelle d'un territoire. Et ce projet rejoint aussi ce qui a actuellement en cours à la Réunion, le projet RenovRisk, qui exploite aussi ces mêmes données d'électromagnétique héliportée pour contraindre... pour expliquer les mécanismes qui déclenchent les grands glissements du cirque de Salazie. Avec l'intérêt que dans cette zone-là, on a aussi beaucoup de points de contrainte de calage géotechnique et historique pour encore mieux interpréter ce que nous donne la géophysique. Et en termes de résultats prometteurs, il y a tout ce qui se passe au niveau de l'aléa volcanique, qu'a évoqué Mathieu, l'imagerie profonde que peuvent nous donner ces techniques. Le BRGM a mis en œuvre cette expertise en magnétotellurie sur Mayotte lors de... ben, actuellement, dans le contexte de la crise actuelle. Et elle nous permet de visualiser la présence de réservoirs magnétiques... sous l'île et d'identifier la profondeur à laquelle ce réservoir se trouve. Ce qui est très important. Actuellement, ce réservoir serait à moins de 20 km de profondeur. Et en termes d'opérationnalité, on peut... Il est d'ailleurs déployé un... proposé un réseau de surveillance pour suivre un peu ces mouvements de magma et mettre en évidence des éventuelles remontées de magma lors d'une prochaine éruption.

-On comprend bien que beaucoup de données ont été collectées grâce à cette méthode d'électromagnétisme héliporté et qui profite à de nombreux projets, je pense. Voilà, c'est ça. Au-delà de ceux que j'ai évoqués, pour d'autres risques naturels... On a évoqué l'aléa sismique. Mais effectivement, quand on veut caractériser l'aléa sismique, on évoque souvent les effets de site. Ce sont des formations géologiques particulières qui vont amplifier les vibrations sismiques. Et donc, qui sont très importantes à caractériser pour mieux adapter l'aménagement du territoire. Donc, actuellement, les données d'électromagnétique sont exploitées pour préciser à Mayotte l'écart d'aléa sismique et du coup avoir une vision... s'aider de ces données-là pour avoir une vision 3D de la géométrie de ces bassins et de ces sites. Et puis, permettre aussi de spatialiser les données ponctuelles géophysiques qui restent indispensables pour caractériser cette amplification sismique, mais là, qui doivent être spatialisées et interprétées et qui le sont grâce à cette vision pseudo 3D. De belles perspectives de développement, donc. Merci beaucoup pour cette explication et d'être intervenue même à distance parmi nous.

-De rien.

-Merci.

Aquanes et Eviban, la recharge maîtrisée des nappes d'eau

Transcription

-On va passer la parole à Géraldine Picot et Marine Pettenati.

-Bonjour, Élodie.

-Bonjour à vous 2. Merci d'être là avec nous. Marie Pettenati, vous êtes correspondante scientifique pour la recherche publique, la Direction de l'eau de l'Environnement, des Procédés et Analyses. et chef de projet hydrochimique, et, Géraldine Picot, vous êtes hydrogéologue. Aujourd'hui, l'eau, c'est critique. Va-t-on manquer d'eau demain ? Tout d'abord, comme l'a dit Dominique, c'est vrai que l'eau est vitale. Nous en avons besoin. Ce qui nous entoure aussi. Les écosystèmes. Et on l'utilise pour différents usages et on doit la partager. Donc, d'un point de vue agricole, industriel, pour l'énergie, aussi les loisirs et évidemment l'alimentation en eau potable. Alors, d'où vient cette eau ? En majorité des eaux souterraines concernant la France métropolitaine. Et elle provient des fameux aquifères, roches poreuses où est stockée la nappe. Donc, de cette nappe, on puise l'eau pour l'utiliser. Et donc, ça peut provoquer des déséquilibres de cette nappe si les entrées et les sorties ne sont plus équilibrées. En gros, s'il y a trop de sorties par rapport aux entrées naturelles, on déséquilibre la nappe. Et c'est vrai qu'on peut aussi la déséquilibrer d'un point de vue qualité, puisqu'en fait, cette eau, elle peut être tout à fait polluée ou pas de la qualité nécessaire à l'usage, ce qui est un autre problème. Et ceci est exacerbé par les changements climatiques qui vont modifier le régime des pluies, qui est la source d'entrée principale d'alimentation de cette nappe. On a compris que le climat est un peu capricieux, donc. On comprend la difficulté.

-Et par-dessus, nos usages vont changer. Nos besoins vont changer en fonction aussi des chaleurs qui vont être provoquées ou des différentes sécheresses, etc. Donc, tout ça, ça va créer des déséquilibres. À la question "allons-nous manquer d'eau demain ?", eh bien, oui. Et on en manque déjà, on le voit. Et donc, pour pallier à ce manque d'eau, à ces besoins qui émanent un peu partout sur notre territoire d'ores et déjà, pas que dans les pays dits secs, eh bien, il y a des solutions qui existent, des solutions d'hydrogéologie. Et ce panel de solutions, on appelle ça la gestion intégrée de la ressource en eau. Et, parmi ces solutions, il y en a une qui nous occupe pas mal depuis plusieurs années, avec Géraldine, mais aussi toutes les équipes en géoscience au BRGM, c'est la recharge maîtrisée des aquifères. Expliquez-nous ce que c'est, parce qu'on veut savoir, du coup. On veut pas manquer d'eau. Oui, une des solutions, c'est cette fameuse recherche maîtrisée des aquifères. Il faut imaginer que l'aquifère a une capacité de stockage considérable dans lequel l'écoulement de l'eau est assez lent par rapport aux autres surfaces, les rivières, où l'écoulement passe trop vite. Et donc, il y a eu cette idée de conceptualiser le fait de stocker de l'eau quand on en a trop pour pouvoir l'utiliser quand on en a besoin. Et donc, c'est ce concept-là de recharge, qu'on appelle aussi recharge maîtrisée ou recharge artificielle parfois... Dans tous les cas, c'est une stratégie pour gérer au mieux des conditions de stress hydrique, mais aussi de qualité des eaux, parce que, quand on va recharger... donc, volontairement la nappe, on va mettre en place tout un panel de solutions techniques, des bassins, des forages, il en existe énormément. On va utiliser des sources d'eau qu'on a à disposition, qui peuvent être de toutes sortes. Ça peut être des eaux de nappe, des eaux dessalées, des eaux de rivière, des eaux usées traitées. Et la capacité de l'aquifère va pouvoir épurer des eaux qui sont pas de bonne qualité pour l'usage.

-Les eaux usées, quand elles passent dans l'aquifère deviennent potables ?

-Heu... Pas usées. Usées, traitées, donc, tout dépend des traitements qu'il y aura eu en amont avant la recharge. Mais l'aquifère peut compléter ce traitement. Et donc, on peut l'utiliser pour ces techniques-là pour ça. Mais aussi, on peut utiliser pour remonter les niveaux d'eau, ce qui va maintenir notre capacité à continuer à puiser l'eau dont on a besoin. ou alors maintenir des systèmes de zones humides en surface, parce qu'il y a des liens entres les autres surfaces et les nappes d'eau souterraines. Et ça peut aussi bloquer des intrusions salines comme on l'a vu tout à l'heure. Quand l'eau douce manque, ou l'eau de bonne qualité manque, on peut bloquer cette salinisation. Donc, voilà, ce sont les techniques de recharge maîtrisée qui dépendent du territoire, des enjeux et de l'objectif qu'on veut atteindre. C'est tout un contexte plus ou moins favorable à cette stratégie. Vous avez mené des projets européens depuis plusieurs années autour de cela. Oui, en effet, on a répondu à des grands programmes de financement européen. Ce sont des appels à projet très compétitifs sur lesquels on se mobilise depuis plus d'une quinzaine d'années, donc, les grands programmes FP6, FP7, HVA20, et qui devient maintenant Horizon Europe. C'est un vrai challenge pour nous de répondre à ces appels grâce à notre expertise. Et puis, il y a aussi les outils de financement tels que le GPI et les projets PRIMA plus focalisés sur la ceinture méditerranéenne et qui nous permettent de collaborer avec des équipes de ces pays-là. Mais on a aussi des soutiens des fonds de soutien interne pour des projets de développement qui nous permettent de faire l'entre-deux entre ces projets et de développer des techniques nous permettant d'être compétitifs sur ces appels à projet. Et puis, ces grands appels à projet qui ont financé ces études sur la recherche maîtrisée des aquifères, c'est aussi une façon de nous permettre de nous mettre en ligne avec l'expertise européenne sur ces thématiques, qui sont assez complexes, qui amènent beaucoup de métiers, de la recherche pluridisciplinaire. Et sur des thématiques qui sont à forts enjeux sociétaux. L'eau, comme l'a dit Géraldine, c'est vital. -On en a tous besoin. -Voilà, on vient à en manquer. Donc, on va se focaliser aujourd'hui pendant notre petit entretien sur un site expérimental qui se trouve en Normandie, le site d'Agon-Coutainville, où on recharge un aquifère dunaire avec des eaux usées traitées. Et, ça, c'est un site qu'on a pu suivre depuis 2016 grâce à 2 projets d'envergure. Le projet HVA20 Aquanes et puis le projet JPI Water Eviban, qui est en cours actuellement. Et donc, Géraldine va nous illustrer, va nous expliquer ce que c'est que ce site. Oui, alors, le site, donc... d'Agon-Coutainville, c'est... Je sais pas si vous voyez à l'écran la vidéo que nous avons préparée. En tout cas, c'est un territoire côtier dans lequel les eaux municipales...

-Donc, là, on voit la station. Voilà, c'est la station d'épuration qui traite l'eau de façon tout à fait classique, comme toutes les stations d'épuration sur le territoire. Mais au lieu de la rejeter dans les cours d'eau, ils ont décidé de rejeter les eaux usées traitées dans l'aquifère dunaire à travers cette roselière, donc, c'est toute cette végétation que vous voyez. Donc, ça, c'est ce qui permet de récupérer l'eau. On la récupère pas, là, on l'injecte, depuis la surface à travers les roseaux. Et cette eau, après, elle poursuit son écoulement dans l'aquifère. Et, sur ce site, il a été décidé de mettre en place cette recharge, donc, il y a déjà un sacré bout de temps. La dernière mise en place, c'était en 2006. Et c'est vrai que, sur ce site, l'enjeu était environnemental, puisqu'il fallait protéger les eaux côtières qui étaient exploitées et qui recevaient la pollution résiduelle des stations d'épuration. Donc, en fait, c'est une épuration qui a été décidée d'être mise en place par l'aquifère et les techniques de recharge. Et là, grâce aux projets Aquanes et Eviban, nous avons pu mettre en place tout un système d'instrumentation sur les eaux souterraines qui reçoivent ces eaux usées traitées, pour connaître, justement, l'évolution de la qualité. Et puis, ben, les niveaux d'eau, quel impact ça avait sur l'intrusion saline. Et toutes ces mesures permettent de comprendre mieux ce qui se passe, les processus. Et c'est justement la thèse, qui est en cours, de Quentin Guillaume Hautot qui nous permettra de préciser tout ça. D'accord. Voilà, on a bien compris comment on pouvait, justement, recharger nos aquifères... En plus, maintenant, on sait ce que c'est. Donc, on a connu 3 années de sécheresse en France. Quelle perspective aujourd'hui on peut envisager par rapport à la recherche ? Que peut-on apporter de plus en termes de gestion de l'eau ? Eh bien, là, justement, on a pu grâce à cette recherche collaborer à ce livre, "Managing Aquifer Recharge : A Showcase for Resilience and Sustainability". En gros, c'est une démonstration sur une trentaine de cas de recharge qui sont décrits pour pouvoir mettre en place des indicateurs de durabilité. Donc, sur 3 piliers : économique, sociétal et environnemental. Et donc, on a participé à la mise en place de ces indicateurs et à la diffusion du savoir-faire donc, là, sur le site d'Agon, mais aussi du savoir-faire BRGM dans le cadre des groupes d'experts de l'Association internationale des hydrogéologues. Alors, comme Géraldine vient de le dire, maintenant, le BRGM a une visibilité européenne internationale. On est incontournables sur ce sujet-là et on dispose des outils qu'on a développés à travers ces projets pour répondre aux enjeux nationaux. Maintenant, à travers nos directions d'action territoriale, on a des remontées des industriels, des demandes des gestionnaires d'eau, des groupements d'agriculteurs. On a aussi des demandes qui sont spécifiques face à cette pénurie d'eau qui s'orientent vers la recharge maîtrisée des aquifères. Et, ça, ça nous a conduits l'année dernière à monter une formation spécifique que nous animons, Géraldine, moi, mais aussi Jean-Christophe Maréchal, qui est à Montpellier dans l'équipe DEPA/NRE, pour former les agents au montage d'offres sur ces thématiques, pour diffuser les moyens d'expertise que l'on a en termes de modélisation de pré-faisabilité des sites, en termes aussi de modélisation pour la gestion de ces sites, mais aussi tout ce qui est nos outils cartographiques d'approches. Oui, vous êtes très sollicités pour partager tout ce que vous avez pu mettre en place, et maintenant à l'international, pas qu'au service de la France. Et on peut que féliciter les équipes et souhaiter qu'on ne manque pas tant d'eau que ça dans les années à venir.

-On va y remédier, Élodie.

-En tout cas, vous y travaillez. Merci beaucoup.

-Merci à vous. Merci aussi.

Cartographie prédictive des submersions liées à un tsunami à Mayotte

Transcription

Bonjour, Anne Lemoine, vous êtes sismologue, chercheuse à la Direction des risques et prévention. Et vous faites partie des spécialistes qui travaillent sur le risque sismique de Mayotte. Que s'y passe-t-il, à Mayotte ?

-Merci. Alors, depuis le mois de mai 2018, Mayotte est le siège d'un phénomène exceptionnel... au niveau géologique. Ça a commencé par des séismes très importants pour la zone qui n'était pas habituée à subir une telle sismicité. Il y a eu divers phénomènes observés. Ça a abouti à la découverte d'un nouveau volcan qui est le plus gros volcan effusif observé depuis 1783. Donc, c'est un bel édifice. Et donc, il se trouve que le BRGM était le seul institut à avoir des stations sismiques sur l'île, sur place. et à avoir une direction régionale aussi. Donc, le temps que la communauté, l'État s'organise pour mettre en place ce qu'on appelle le REVOSIMA, le réseau de surveillance dédié, c'est le BRGM qui a été chargé de suivre ces phénomènes au départ. Une vraie fierté, d'ailleurs. Et donc, j'imagine qu'au regard de ce que vous avez découvert, la question des risques s'est posée. Pouvez-vous nous en parler ?

-Oui, la question des risques s'est posée tout de suite, effectivement. D'autant plus que, comme vient d'en parler Gilles, au BRGM, on est sensibles à un certain nombre de ces sujets, risques sismiques, tsunamis, etc. Et, en fait, dès le départ du phénomène, on s'est posé des questions par rapport à de potentiels impacts. Après, je vais plus spécifiquement parler des tsunamis. En tant que sismologue, je faisais partie de l'équipe qui suivait la séquence sismique, au départ, du phénomène. Et je fais aussi partie de l'équipe de tsunami du BRGM. Et, dans cette équipe, il y avait un collègue, Rodrigo Pedreros, qui avait travaillé auparavant sur une étude... d'estimation de la submersion liée à des cyclones. Donc, il connaissait le territoire, ainsi que les données nécessaires à une bonne prise en compte des spécificités pour bien simuler la submersion liée aux cyclones. Donc, assez rapidement, dès mars 2019, il y a des modèles préliminaires de tsunamis qui ont été construits. Et après la découverte du nouveau volcan, en mai 2019, le ministère de l'Environnement a chargé le BRGM d'une étude exploratoire d'évaluation d'impact tsunami à travers des modélisations de 3 types de sources de tsunamis, source sismique, source via des glissements sous-marins et source liée à de potentiels effondrements de réservoirs magmatiques. Et quels résultats vous avez pu avoir grâce à cette étude ?

-En fait, lors de ce travail exploratoire, on a proposé une soixantaine de scénarios différents. Et pour chacun de ces scénarios, on a construit des modèles de tsunamis. Alors, sur l'écran, on voit un petit film qui représente la propagation du tsunami au voisinage de Mayotte. Là, on est sur un scénario. C'est un modèle numérique. Donc, on a imaginé une source de tsunamis qui se trouve être un glissement à l'est de Mayotte. Un glissement plutôt important. On a "maximinisé" les hypothèses pour, on va dire, rester conservatif. Donc, là, les couleurs représentent l'amplitude des vagues. Les petites flèches représentent les vitesses de l'eau. Et ce qu'on peut voir sur cette vidéo, par exemple, c'est que le récif est souligné par la propagation du tsunami, parce que le tsunami, en arrivant sur le récif qui borde le lagon, dissipe une partie de son énergie. Donc, on voit avec ce genre de film la manière dont peut se comporter un tsunami. Et donc, on a décliné les 60 scénarios. Et puis, pour les scénarios les plus impactants, des simulations plus haute résolution ont été menées afin d'estimer de manière la plus réaliste possible la submersion potentiellement associée. Donc, en fait, Mayotte, c'est un territoire particulièrement difficile pour modéliser des tsunamis. En fait, élaborer des modèles de tsunamis comme ceux qu'il faudrait faire dans l'idéal ça représente un certain nombre de challenges, techniquement parlant. D'une part, on est dans le cadre d'un phénomène qui est actif, avec des sources tsunamigènes...

-Ça bouge tout le temps. Ça bouge et il y a des sources qui sont proches de l'île. Donc, il ne faut pas qu'on rate une hypothèse, quelque part. Et puis, techniquement, en termes de modèle hydrodynamique, on est contraint par l'utilisation de certaines règles. Les sources étant proches, on doit aller vers certains outils de modélisation qui sont très spécifiques et très pointus. D'autres spécificités comme le fait que les dimensions des sources tsunamigènes sont plutôt petites au regard de l'épaisseur de l'eau au-dessus des sources nous obligent à utiliser des modèles assez pointus et à élaborer des modélisations numériques assez complexes. Et, en parallèle de ce projet exploratoire, des projets de recherche ont été menés. Notamment dans le cadre de collaborations avec des collègues de l'Institut de Physique du Globe de Paris. Donc, à travers la thèse, notamment, de Pablo Poulain. Une thèse qui est codirigée par notamment Gilles et des collègues de l'Institut de Physique du Globe de Paris. Donc, on a intégré un nouveau niveau de complexité. Et ce niveau de complexité est représenté ici sur cette vidéo. L'image en haut à gauche représente une image de la source. En rouge, c'est la zone de la pente qui va être déstabilisée, c'est-à-dire qui va...

-Se décrocher. Et, sur la vidéo, on voit en ombre au fond de l'eau... le déroulement de cette déstabilisation des sédiments le long de la pente. Et, en parallèle... Le fait que les sédiments glissent le long de la pente, ça va déstabiliser la colonne d'eau, ça va générer un tsunami. Et le tsunami va se propager dans le bassin. Et, ce que l'on voit sur cette vidéo, c'est que, dans cette hypothèse, qui intègre la dynamique, c'est-à-dire l'histoire de l'écoulement du glissement, le glissement n'a pas terminé de descendre que les 1res vagues arrivent déjà à la côte. Donc, la dynamique du phénomène est très complexe et nécessite numériquement d'avoir les outils tout à fait adaptés.

-Oui...

-Au risque de mal évaluer l'impact. Et du coup, d'avoir une mauvaise prédiction. Justement, ces outils sont-ils complètement au point ? Alors, les outils... Pour mener à bien cette simulation, il y a de 1ers développements qui ont été établis, c'est-à-dire que des codes ont été couplés, des codes de modèles. Notamment un modèle qui travaillait sur la manière dont le glissement dévalait les pentes qui a été couplé avec un code qui travaillait sur la manière dont le tsunami se propageait dans ce bassin très spécifique, avec un récif sur lequel les vagues peuvent déferler. Des spécificités même au niveau des côtes, très particulières. Et, pour aller au-delà, en fait, ce qu'il faudrait, c'est avoir un effet plus intégrateur, avoir des codes qui soient aussi bien satisfaisants au niveau d'une génération de sources complexes et qui puissent répondre aux spécificités du terrain en termes de codes hydrodynamiques. Et donc, en parallèle de ces travaux... Tous les travaux qu'on a menés jusqu'à présent nous ont permis... C'est comme un cas d'école. Ça nous a permis de cibler les efforts et de savoir développer ou développer...

-Oui.

-Les outils. Et, au sein des équipes du BRGM qui travaillent sur ce genre de modèle, des collaborations ont été menées aussi avec l'Inria, notamment par le développement d'un code, UHAINA, qui va pouvoir nous permettre, grâce à une spécificité très intéressante, on appelle ça un maillage non structuré, alors, il a plein d'autres qualités ce code, mais, ce qui est très intéressant par rapport à ça, c'est que ça nous permet, là où on a des données fines, ou là où on a un enjeu particulier, où on veut faire des simulations très fines, ou là, par exemple, d'affiner la résolution au niveau de la source, parce qu'on a une source très difficile à simuler avec des données complexes. Donc, on peut avoir... affiner nos modèles en fonction des sites sur lesquels on doit porter notre intérêt. Et donc, par ailleurs, à Mayotte, une autre caractéristique de cette île qui subit un phénomène actif, c'est que c'est une île qui est très mal connue géologiquement parlant. Mais, ces dernières années, ces derniers mois, il y a eu un grand nombre de campagnes d'acquisition, de campagnes en mer, de campagnes à terre, qui permettent de mieux connaître le terrain, les matériaux, les structures actives. Donc, l'étape suivante, c'est de continuer le développement des outils adaptés à une meilleure prise en compte... à une meilleure simulation haute résolution des effets d'un tsunami et de la submersion en particulier. Et puis, intégrer la meilleure connaissance qu'on a des objets géologiques et des structures actives pour avoir des sources réalistes et modélisées de manière réaliste. Un dernier aspect, c'est qu'il faut qu'on aille au-delà de la modélisation du phénomène et qu'on intègre les modèles... qu'on intègre l'aspect dommages dans nos modèles, dommages sur les infrastructures et les bâtiments. Ça, c'est...

-Protection de la population aussi, bien évidemment. Mais on voit qu'il y a déjà de belles évolutions. Quand on voit vos modélisations, on imagine ce que ça peut donner par la suite quand tout ça sera encore plus développé avec la précision que ça pourra apporter. Ce qui est intéressant dans ce sujet aussi, c'est que c'est un... Le sujet dont on parle, c'est très intégrateur dans le sens où c'est un sujet qui est très pluridisciplinaire. Et, dans le cas de Mayotte, comme l'a dit Gilles tout à l'heure, c'est un sujet qui a mobilisé de nombreuses spécialités, de nombreux instituts et toute une équipe de chercheurs avec des casquettes très différentes.

-La transversalité.

-Oui.

-Merci beaucoup.

-Merci.

-Merci à tous les 2.

Caractérisation et prédictivité des transferts de contaminants en lien avec l’érosion en contexte d’après-mine

Transcription

Nous accueillons Thomas Grangeon, la Direction des Risques et Prévention, et Mathieu Debure à la Direction de l'Eau, de l'Environnement, des Procédés et Analyses. Vous menez un projet qui s'appelle "Transport". Il est innovant, parce qu'il réunit 2 communautés scientifiques, à la base pas faites toujours pour travailler ensemble. Pouvez-vous nous expliquer cette originalité ? Oui, c'est vraiment le gros intérêt de ce projet. On réunit 2 communautés, typiquement celle de Mathieu, qui étudie de manière très fine et avec une très bonne compréhension le transfert de contaminants dans l'environnement, globalement la chimie de l'environnement. Et par ailleurs, la communauté qui est plutôt la mienne, celle de l'érosion des sols, qui est plutôt tournée vers la compréhension de comment est-ce que les particules sont érodées et ensuite transférées dans l'environnement. Donc, les questions associées à cette thématique sont assez variées. Mais une de celles qui nous agite beaucoup, c'est celle de la sécurité alimentaire. On imagine que quand il y a de l'érosion des sols, que cause la pluie qui va mettre en suspension ces particules et les transférer en aval sous l'effet du ruissellement... On le voit, quand on est sous une averse, on voit de l'eau un petit peu marron. Et ça, ça a de gros impacts, car on a pu voir à la fois dans la bibliographie et nos études que ces phénomènes pouvaient être très importants. En effet, on mesure des taux d'érosion, donc, des pertes en sol local pouvant être plusieurs ordres de grandeur supérieures au taux de production naturel de ces sols. Donc, on perd du sol plus vite qu'on le produit. Donc, sachant qu'on utilise le sol pour le cultiver, ça a de gros impacts derrière. L'un des impacts qui nous concerne plus dans le cadre de ce projet, c'est le transfert de contaminants associés. Nous, dans notre communauté, on a tendance à admettre, sans toujours le comprendre, que ces particules contiennent des substances chimiques. On sait pas trop comment, si elles sont scotchées dessus... Ça, pourtant, c'est le cœur de métier de toute une communauté, qui est celle de Mathieu qui étudie ça très très bien. Donc, ce projet doit permettre d'aboutir à une compréhension un peu plus globale du transfert de contaminants dans l'environnement.

-Comme le disait Thomas, donc, nous, ce qui va nous intéresser principalement, c'est la géochimie. Dans "géochimie", on a "géo" pour tout ce qui est un peu roche. Et "chimie", il faut imaginer, si vous faites appel à des souvenirs de collège, le tableau de Mendeleïev avec tous les éléments du tableau périodique. Donc, on étudie un petit peu ça et majoritairement dans l'eau. Aujourd'hui, on a beaucoup parlé d'eau. C'est bien d'en avoir, mais encore faut-il que cette eau, on puisse la boire, se baigner dedans... Et dans ces différents éléments chimiques, on a des éléments auxquels on aimerait s'affranchir. Du moins, on aimerait pas les retrouver dans l'environnement. On peut citer le plomb, l'arsenic, le zinc, tout un tas de choses qu'on peut retrouver dans des activités entropiques, c'est-à-dire humaines, qui peuvent être les activités minières ou alors des activités plutôt industrielles. Donc, nous, on étudie ça principalement, comme le disait Thomas, sous forme dissoute. Et on regarde finalement pas trop le solide. Quand on regarde le solide, c'est surtout les interactions que peuvent avoir ces éléments chimiques avec le solide. Mais on va pas regarder le transport du solide dans l'environnement. Transport, c'est emmener de la matière d'un point A à un point B, comme on prendrait le train de Paris à Marseille, par exemple. Et donc, c'est étudier toute cette migration d'éléments dans l'eau, mais en s'affranchissant quelque part de toute la complexité du transport particulaire. Au niveau particulaire, ce qu'on regarde de temps en temps, c'est les toutes petites particules qui sont inférieures à un micron, qu'on appelle généralement colloïdes. Ça, c'est vraiment la seule chose qu'on peut regarder. Tout le reste, on sait que ça existe, mais on a tendance à s'en affranchir. D'où l'intérêt du projet de faire communiquer 2 communautés où on sait que le transport particulaire influe sur le transfert de polluants dans l'environnement, le dissout aussi. Mais on sait pas quelles sont les interactions. D'ailleurs, vous étudiez des sites bien spécifiques que sont les sites miniers. Oui, on a centré ce travail sur les terrils miniers. Pour 2 grandes raisons. Premièrement, Dominique en a un peu parlé, c'est une des missions du BRGM de s'occuper de ces sites miniers. Les sites miniers, moi, avant, ça m'évoquait le nord de la France, typiquement ces terrils-là. Mais des terrils, il y en a un peu partout en France. Et aujourd'hui, il faut composer avec. Donc, ça, c'est la mission du DPSM de travailler à la gestion de ces sites. Et nous, on est là pour apporter une aide à la compréhension de la dynamique de ces sites et in fine à la création d'outils qui vont aider à la gestion de ces sites. La 2e raison pour laquelle on s'intéresse aux terrils, c'est que du point de vue de l'érosion, c'est des entités qu'on comprend mal. On est pas au clair sur les processus qui génèrent leur érosion. En effet, un terril, c'est hyper dynamique au niveau de l'érosion. On le voit bien, un terril... C'est ce qui vous est illustré ici. Pour donner un ordre de grandeur, on est sur un terril qui fait environ 100 m de longueur sur une vingtaine de mètres de hauteur. Et c'est incisé de partout par des ravines. Donc, c'est un transport particulaire super intense. Et ça met en défaut les méthodes de suivi qu'on a habituellement. Du coup, un des points de blocage qu'on a attaqué dans ce projet, ça a été de quantifier cette érosion, essayer de comprendre comment elle fonctionnait. Pour ça, on a utilisé un scanner laser 3D, qui nous a permis de prendre des photos numériques du terril à différents temps et de regarder comment il évoluait dans le temps et donc d'en déduire du transport. On est que 2 à présenter aujourd'hui, mais ce travail a été mené en collaboration avec pas mal de personnes. On a parlé de communautés... On pouvait pas faire venir tout le monde. Mais oui, ça regroupe beaucoup de chercheurs. Vous parliez donc de cette érosion qui, de facto, a un impact environnemental important. Oui. À cet effet, on a une illustration... Là, ce sera plutôt l'illustration précédente, où, justement, on voit un joli petit terril minier en arrière-plan. Donc, ça peut être plutôt joli, c'est végétalisé, c'est quelque chose qui a repoussé sur le terril à proprement parler. Comme Thomas disait, on en trouve dans le sud de la France. On peut avoir différentes activités. Sur celui d'Abbaretz, jusqu'à récemment on pouvait se balader dessus en s'affranchissant, en fait, de tous les problèmes de pollution qui peut y avoir. Donc, ce que vous voyez au 1er plan, c'est de l'eau qui s'écoule avec à l'intérieur une couleur plutôt orangée. Donc, cette couleur orangée, elle est principalement issue des hydroxydes de fer. C'est quelque chose que vous pouvez voir dans votre jardin. Si vous mettez une barre de fer qui est soumise aux intempéries, au bout d'un moment, elle va finir par rouiller. Et c'est un peu ce qu'on voit là. Le problème, c'est qu'outre les hydroxydes de fer, on a aussi des polluants, les éléments chimiques déjà cités, plomb, arsenic, et cetera... qui peuvent s'écouler à l'intérieur de l'ancienne mine. Mais le site est pas totalement fermé. Ça s'arrête pas juste à la sortie de la mine. Et derrière, ça peut aller dans l'environnement et notamment dans les cours d'eau. Donc, le point important que l'on voit à peu près au milieu... On a l'impression qu'on a commencé à éventrer le terril. En fait, c'est des choses qu'on appelle des ravines. C'est principalement dû à des événements pluvieux qui peuvent être plutôt intenses, ou alors un manque de stabilité du terril. Et ça, ça apporte d'autant plus des éléments dans l'environnement. Des éléments sous forme particulaire, mais aussi sous forme dissoute. Donc, on essaie de... La source, globalement, quand il s'agit de mines, on l'a, on sait que la source, elle est là. On sait à peu près les modes de transfert. Par contre, on connaît pas tous les processus. Et c'est ça qu'on essaie de décrire dans ce projet. Pardon, je croyais que vous vouliez prendre la parole. Donc, là, le projet n'est pas terminé. Qu'avez-vous comme perspective à venir sur cette étude ? Est-ce qu'on peut empêcher... ces écoulements ? Comment on peut préserver ces écoulements ?

-Ce projet, effectivement, est encore en cours. On a d'abord eu besoin de défricher le terrain au niveau de la mesure afin de comprendre un peu le 1er processus et avant ça d'être capable de quantifier les choses. Donc, ça, c'est un acquis de la 1re année. Maintenant, ce vers quoi on va tendre dans la suite de ce projet, ça va être de développer la conceptualisation des processus et comment on peut les intégrer dans un modèle numérique qui permettra de prendre en compte à la fois le transport particulaire et le transfert de contaminants associés comme Mathieu et ses collègues sont capables de le décrire. Et donc, ça va être essayer d'intégrer cette connaissance dans un outil numérique qui nous permettra à terme d'aider à la création de plans de gestion de sites.

-D'accord. Merci beaucoup. Merci, messieurs.

De nouveaux modèles pour évaluer l’impact de la transition énergétique sur l’environnement

Transcription

Pour illustrer le projet MINTECO, nous accueillons Gaëtan Lefebvre, économiste à la Direction des géoressources, et Daniel Monfort-Climent, vous êtes chercheur à la Direction de l'Eau, de l'Environnement et des Procédés et Analyses. Donc, en 2020, vous avez mené un projet. Pouvez-vous nous parler de ce projet SURFER ? Bonjour à tous. D'abord, je l'ai pas mené tout seul, on était plusieurs dans l'aventure. Donc, je les salue d'ici. Au sein du BRGM, on était plusieurs personnes, au sein de la DEPA, mais aussi au sein du DGR. Donc, c'est un projet entre 2 directions. Donc, c'est un projet coordonné par le BRGM avec un cofinancement de l'ADEME et un partenariat avec le CNRS ISTerre, un laboratoire de géoscience à Grenoble. La question initiale de ce projet, c'était la transition énergétique, quelle est la demande, croissante, en matériaux, en métaux, comme Patrick vient de le signaler, de cette transition énergétique. Ne passe-t-on pas d'une dépendance, quelque part historique, du mix énergétique des énergies fossiles, du pétrole, du charbon, du gaz vers une dépendance de plus en plus croissante des métaux ? Et toutes les questions associées... Y a-t-il des transferts d'impacts ? Comme Patrick l'a dit aussi, beaucoup de ces métaux vont être extraits ailleurs. Ça, c'était la question initiale de ce projet, mais il y a longtemps. Là, on termine le rapport final, mais le projet a démarré en 2017. Donc, c'est... Et puis, c'est pas fini, la question reste...

-Complètement d'actualité.

-Complètement d'actualité. Et donc, comment a commencé ce projet justement ? Une des questions initiales qui se sont posées... Enfin, mes collègues, parce que je suis arrivé un peu plus tard dans l'équipe, c'était la question des données. pour faire des prospectives dans les autres matières. On s'apercevait que tout le monde utilisait les mêmes données et qu'on ne faisait pas une revue critique de la donnée qu'on utilisait, des contenus matière de toutes ces installations, c'est-à-dire combien d'acier il faut pour une éolienne, combien de terres rares pour un générateur d'éolienne. Tout le monde utilisait les mêmes données et on se posait pas la question de l'origine, de l'hétérogénéité, etc. Donc, nous, on a été...

-Vous vous êtes interrogés. On a été un peu bourrins et on est allés récupérer le maximum de données possibles qu'on trouvait dans la littérature scientifique et technique, dans les rapports, et on les a harmonisées. On les mises dans une base de données, basée sur une base de données d'un projet précédent, ProSUM, un projet européen, et, finalement ce travail, c'est un gros travail d'harmonisation, de lecture de beaucoup de papiers. On a mis un peu tout l'acier, le cuivre, les terres rares, tout le cobalt pour une batterie électrique, parce que le périmètre c'est transition énergétique. Il y avait la génération de l'électricité, mais il n'y a pas que ça. On s'intéressait aussi à la batterie des véhicules électriques, mais aussi à des équipements auxquels on ne pense pas forcément. Tout ce qui est génération de chaleur, réseaux de chaleur, géothermie, pompes à chaleur et même jusqu'au poêle à granulés, pour vous donner un exemple. Ça va d'une centrale nucléaire jusqu'au poêle à granulés. Et donc, une fois harmonisées toutes ces données-là, avec un objectif de trouver une unité commune, ce qu'on appelle l'intensité matière, c'est-à-dire la quantité de matière, mettons d'acier, de laiton, de cuivre, d'aluminium qu'il faut pour une unité de performance énergétique, une unité d'énergie... En général, on travaille plutôt avec des mégawatts, la capacité à installer dans une centrale, ce qui nous permet de comparer.

-On avait un visuel, d'ailleurs.

-Oui.

-Voilà, là, on a une vue d'ensemble. Je vous laisse commenter. Donc, ça, c'est un graphique qu'on a produit dans le cadre du projet SURFER, où on voit la quantité d'acier rapportée en tonne par mégawatt des différentes centrales de production d'électricité. Donc, on voit que certaines technologies, il y a une très forte dispersion, qui s'explique par plein de raisons. Parce qu'on peut être en train de comparer des choses très différentes entre elles. On voit quand même que le gaz, le charbon, le nucléaire, c'est des centrales très centralisées. Enfin, ça va dans le mot "centrale". Donc, il y a beaucoup d'acier dans ces centrales. Mais rapporté aux puissances très fortes de ces centrales, on observe une intensité matière plutôt faible. Et ce qu'on voit, c'est que l'hydro... Mais l'hydro, c'est spécifique. Mais l'éolien, notamment, l'intensité matière en acier est beaucoup plus importante rapportée aux mégawatt-heures, c'est-à-dire qu'une des lectures qu'on peut faire de ce graphique, c'est se dire que pour l'équivalent d'un réacteur nucléaire, qui en gros fait environ 1 000 mégawatts, il faudrait... Une éolienne, c'est entre 2 et 3 mégawatts. Donc, déjà, on fait les comptes. Et rapporté à la quantité d'acier, c'est-à-dire pour remplacer un réacteur nucléaire, qui tourne, en plus, avec un facteur de charge plutôt à 80 %, alors que les éoliennes sont plutôt à 30 %, bref, on a commencé à faire ce genre de calculs pour se dire : "Attention, il y a un enjeu matière." Un enjeu pour l'acier, mais pour le béton, pour le cuivre, qui sont en plus des matériaux et des métaux présents dans toutes les infrastructures. Alors que parfois, on parle beaucoup de terres rares qui concernent que quelques technologies alors que le cuivre, l'aluminium et l'acier sont plus importants. Du coup, on comprend que là où on a tendance à peut-être valoriser une énergie de type éolienne par rapport au nucléaire, plus controversé, il y a d'autres enjeux derrière qui se jouent et font qu'on n'a pas de solution ni unique ni neutre. Tout à fait. La question du projet, c'est : tout est dans la nuance et dans la contextualisation. Et c'est vrai qu'il n'y a rien sans rien. C'est un peu la réponse du projet. Et que l'enjeu de matière, accompagné aussi à des enjeux d'économie circulaire, parce que la question qu'on se pose actuellement... Quel est le rôle de l'économie circulaire ? Quelle est la compensation du recyclage pour atténuer la pression sur la ressource primaire ? Merci, Daniel. Gaëtan, quant à vous, vous avez mené un autre projet qui s'inscrit dans le programme des ressources minérales et de la transition bas carbone. Présentez-nous ce projet qu'on appelle CGDD. CGDD, parce que c'est mené par le Commissariat général au développement durable français. Donc, le BRGM a été sollicité avec d'autres partenaires, dont le CEA. C'est un projet qui s'étend sur 2 ans. Pardon, 3 ans, entre 2019 et 2021. Donc, il se finira en 2021. Mais il y a eu 4 groupes de travail sur cette période. Les deux 1ers, entre 2019 et 2020. Le 1er était sur le photovoltaïque. Et le 2e, sur les réseaux électriques et le stockage de l'énergie. Et déjà, les enjeux associés à ce projet sont assez similaires au projet SURFER. Il s'agit de caractériser le besoin en matière pour toutes les technologies de transition énergétique bas carbone. On a parlé d'éolien, on a parlé de solaire et de stockage de l'énergie. C'est le 1er objectif, mais il est associé à un objectif un peu plus politique. On voulait aussi avoir une vision des impacts environnementaux et sociétaux qui peuvent être associés au choix des différentes technologies. C'est comme ça que nous a été présenté le projet. Donc, on s'est très vite rendu compte que répondre à ces questions est beaucoup plus complexe qu'il n'y paraît et que, comme on l'a vu avec Daniel, c'est pas juste un choix entre une technologie et une autre, ça implique vraiment énormément d'aspects, à la fois matière, mais aussi environnementaux et sociétaux. Il y aurait des freins sociétaux ? Bien sûr. On peut donner l'exemple du photovoltaïque... En fait, le BRGM a surtout apporté son expertise sur la connaissance des chaînes de valeur, c'est-à-dire que sur le photovoltaïque, on compare, par exemple, des technologies au silicium aux technologies cadmium tellure. Donc, déjà, les matériaux ne sont pas les mêmes. L'énergie utilisée, par exemple, pour les panneaux au silicium est supérieure à l'énergie utilisée pour les panneaux cadmium tellure. Or, le cadmium est réputé un métal plus toxique que le silicium. Donc, dans ce cas-là, quel choix faire ? Étant donné que l'analyse de la chaîne de valeurs permet aussi de voir que, par exemple, les technologies au silicium sont essentiellement dominées par des compagnies chinoises. Le cadmium tellure est plutôt sous emprise d'une seule compagnie qui, elle, est américaine. On voit très vite tous les enjeux qu'il peut y avoir derrière. D'accord. Merci beaucoup. Et du coup, le BRGM, au-delà des recherches qu'il mène, comment il peut s'impliquer aussi, justement, et mettre à profit ces recherches pour peut-être un peu dénouer ces débats sociétaux ? C'est vrai qu'on dirait que le BRGM est plus dans la production d'informations et de connaissances à ce niveau-là. Et donc, c'est vraiment influencer les recommandations qui peuvent être faites sur ces rapports qui sont publics et qui sont disponibles à tout le monde. Ensuite, le BRGM a vraiment ce rôle d'éclairer sur ces enjeux, de le mettre à disposition de l'État également. Et en ce sens, essayer, pour les suites d'un tel projet, c'est vraiment essayer d'orienter les investissements, avoir des investissements ciblés dans des start-ups pour améliorer la souveraineté de ces chaînes de valeur... que finalement on connaît bien, mais peut-être aussi améliorer les incitations réglementaires sur ce sujet-là. C'est les 2 objectifs principaux qu'on peut voir et qu'on espère apporter. Ça illustre bien un des axes que vous aviez exposé en termes de stratégie d'économie, c'était juste pour rebondir, puisque ça permet de mieux visualiser avec un projet comme ça concret vers quoi on cherche à tendre. Eh bien, merci, messieurs. Merci à vous. Merci.

Estimer le potentiel géothermique sur aquifère superficiel, une méthode innovante mise en oeuvre sur la métropole d’Orléans

Transcription

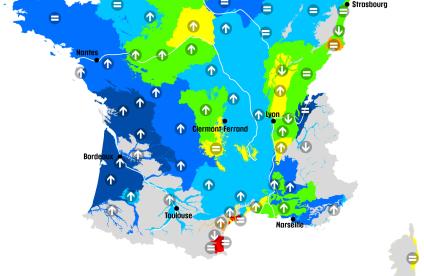

Je donne la parole à Charles Maragna, chercheur, qui est sur un projet innovant qu'il nous présente. Mais d'abord, peut-être va-t-il nous expliquer ce qu'est la géothermie de surface. La géothermie de surface, ça consiste à exploiter l'énergie thermique contenue dans le sous-sol entre 0 et 200 m de profondeur. Donc, on est sur des systèmes beaucoup moins profonds que ceux évoqués par Sylvie. Donc, pour chauffer, climatiser, rafraîchir les bâtiments ou leur fournir de l'eau chaude sanitaire. C'est généralement via une pompe à chaleur, qui va consommer un peu d'électricité. Mais finalement, on a des systèmes qui sont relativement efficaces, car 60 à 80 % de l'énergie restituée au bâtiment est extraite gratuitement, entre guillemets, du terrain. C'est une technologie mature, silencieuse, qui n'émet pas de particules fines, qui peut même fournir du rafraîchissement quasiment gratuit en été. C'est ce qu'on voit sur le schéma. On a à gauche le principe de fonctionnement d'une pompe à chaleur. Et on peut récupérer l'énergie thermique du sous-sol de différentes manières. Donc, en haut à gauche, on a une sonde verticale. C'est un forage avec des tubes à l'intérieur dans lesquels va circuler un mélange d'eau et d'antigel qui va se réchauffer ou se refroidir au contact du terrain. On peut en mettre plusieurs centaines pour des gros bâtiments. C'est ce qu'on appelle un champ de sondes. Pour une maison individuelle, si on a assez de place, on peut utiliser des échangeurs horizontaux. Là, on va vraiment exploiter 1 ou 2 m de terrain. Et autre système, c'est le doublet avec 2 puits. On a un puits pour pomper de l'eau souterraine. On y prélève de la chaleur ou du froid suivant l'usage que l'on veut faire en surface. Et puis, on réinjecte cette eau via un 2e puits un peu plus loin. Donc, là, la différence avec ce que nous a présenté Sylvie Gentier, on n'est plus sur les mêmes techniques. Et en termes d'innovation, vous avez lancé une recherche de potentiel de géothermie à Orléans métropole. Oui, on a eu un projet partenarial avec la métropole d'Orléans pour développer une cartographie du potentiel de la géothermie en croisant différents types de données. Des données relatives aux besoins énergétiques en surface. Donc, les besoins énergétiques des bâtiments. En prenant aussi en compte les propriétés géologiques et hydrogéologiques, les différentes contraintes réglementaires et les contraintes liées à l'implantation. Globalement, on a travaillé à la maille IRIS. Les mailles IRIS sont des mailles statistiques de taille variable. Il y en a 117 sur la métropole. Et c'est sur ces mailles IRIS...

-Les mailles, ce sont des localisations ?

-De taille assez variable. Ça peut aller de tout Saint-Cyr-en-Val jusqu'à des petites zones du centre. C'est souvent basé sur le nombre d'habitants. Donc, suivant l'intensité de population, ça peut être plus ou moins étendu. Ce qui est intéressant, c'est qu'on avait des données énergétiques disponibles sur ces mailles. Et sur chaque maille, on a estimé la quantité de chaleur que pourraient fournir des sondes géothermiques verticales ou des doublets. D'accord. Donc, là, une grande étude, 117 points. Et qu'est-ce que ça a donné cette étude aujourd'hui ? Alors, sur ces 117 points, on a déterminé des consommations... Enfin, on est reparti de consommations énergétiques qui avaient été estimées par le bureau d'études "Artélis". Eux, ils ont travaillé à la maille IRIS. On voit que la maille IRIS, par exemple, de Saint-Cyr-en-Val, c'est une seule maille IRIS. Donc, on avait une donnée sur toute la maille. Et la 1re difficulté qu'on a eue, c'était de redistribuer ce besoin énergétique sur des zones... Enfin, sur les zones bâties. On a fait des croisements entre les bases de données de l'urbanisme et les données énergétiques. Donc, là, la carte, le bleu foncé, c'est bien ou c'est pas bien ? Alors, c'est là où la consommation énergétique est la plus faible. Donc, en gros, ça correspond à la périphérie de la métropole. Et dans le centre d'Orléans...

-Une grosse consommation. Voilà, la consommation est beaucoup plus élevée. Et donc, au final, on a redécoupé les 117 zones en 536 zones, où on a considéré que les consommations sont homogènes. D'accord. Et par rapport à la réglementation, il y a des contraintes ? Alors, la réglementation, elle est relativement peu contraignante. Enfin, elle n'empêche pas le développement de projets sur la plus grande partie de la métropole. Donc, d'un point de vue du Code Minier, on est sur des régimes déclaratifs, éventuellement avec avis d'experts sur la grande majorité de la métropole. Donc, ça évite d'avoir à déposer des dossiers, des demandes d'instruction. Jusqu'à de gros projets, des immeubles qui seraient raccordés à la géothermie. Il y a 2 petites contraintes... Il y a une contrainte supplémentaire qui est la prise en compte des périmètres de protection rapprochée des captages d'eau potable. Là, on ne bénéficie pas de ce régime déclaratif simplifié. Il faut déposer des demandes d'autorisation. Ce qui peut être assez long. Et on a des contraintes aussi sur les nappes réservées à l'alimentation en eau potable.

-Ça représente beaucoup sur notre métropole ?

-Oui, il y a une bonne partie... Voilà, on peut voir en orange les périmètres de protection rapprochée sur la carte. Donc, ça, ce sont les zones sur lesquelles le régime simplifié ne s'applique pas. Il faut repasser par une autorisation. On voit que ça représente que quelques pour cent de la superficie totale de la métropole. Vous parliez du Code Minier. Les plans locaux d'urbanisme peuvent-ils être aussi intégrés dans cette réglementation ou pas du tout ? Alors, là, on a regardé uniquement la réglementation relative au sous-sol. En revanche, les plans locaux d'urbanisme incitaient les aménageurs, ou disons les propriétaires de bâtiments, ou les aménageurs de nouvelles zones à développer tel ou tel type d'énergie renouvelable. Ça peut être aussi un des leviers d'action pour le développement de la géothermie. Avec cette étude, j'imagine que vous avez eu des résultats, bons ou mauvais. Vous allez nous le dire. Quelles avancées vous avez eu en 2020 sur ce projet de géothermie de surface ? Alors, oui, je vais parler des avancées. Il y a juste un point à mentionner avant, c'est qu'on a aussi collecté des données relatives aux aquifères et aux propriétés thermiques et hydrodynamiques du sous-sol. Donc, on est repartis chercher des données de thèse de pompage. Au final, on n'avait qu'une vingtaine de points sur la métropole. Mais même sur les puits les moins productifs, finalement, les principales formations aquifères sont capables de fournir un débit tout à fait suffisant pour alimenter même de grandes opérations. Ensuite, on a réalisé... Toujours sur la méthodologie, on a réalisé une étude... Enfin, on a modélisé un aquifère... Enfin, un doublet sur aquifère... Voilà, là, on voit les 2 formations qui sont principalement visées. Ce sont les calcaires de Pithiviers et les calcaires d'Étampes qui sont à quelques dizaines de mètres de profondeur et qui sont capables de fournir de l'eau en grande quantité pour alimenter des pompes à chaleur. Et sur la planche suivante... Voilà, ce qu'on a fait en haut à gauche, c'était modéliser un doublet avec différentes caractéristiques d'écoulement souterrain, de types de besoin, et cetera... Donc, on a modélisé cet ensemble de puits qui prélèvent de l'eau souterraine pour chauffer ou rafraîchir un bâtiment. On a des écoulements qui sont assez importants sur la métropole. On voit sur le 1er schéma en haut, ça va avoir tendance à envoyer tout le panache de température dans une direction de l'écoulement. Ça, on l'a fait dans des logiciels de modélisation des écoulements souterrains. Et ensuite, on a pu en déduire des tailles de gélules... des tailles de panaches de zones impactées thermiquement par un doublet. Et ensuite, ça, on l'a utilisé dans un outil de traitement cartographique pour estimer jusqu'à combien de doublets on pourrait positionner sur la métropole pour pourvoir les besoins énergétiques. Et donc, pour en arriver aux résultats, on arrive à la conclusion que la 1re couche aquifère pourrait couvrir de l'ordre de 25 à 30 % des besoins énergétiques de la métropole. Donc, le calcaire de Pithiviers. Et le calcaire d'Étampes pourrait couvrir de l'ordre de 30 à 40 % des besoins. Sans rentrer dans les détails, on a aussi fait un travail sur les sondes géothermiques verticales en développant des méthodes qui permettent de prendre en compte le foncier disponible. Et là, on arriverait de l'ordre de 50... On pourrait couvrir de l'ordre de 55 % des besoins énergétiques avec des sondes de 100 m et encore plus avec des sondes de 200 m.

-Et qui va pouvoir se saisir maintenant de tous ces résultats obtenus ?

-On les a remis à la métropole. Et c'est en cours d'intégration dans leurs schémas directeurs des énergies pour comparaison avec d'autres sources d'énergie renouvelable.

-La métropole pourrait donc s'emparer de la géothermie de surface prochainement ?

-Oui, cette énergie étant mise en avant systématiquement dans leur PCAET, plan climat-air-énergie territorial.

-Très bien. Merci beaucoup.

-Merci.

Intelligence artificielle et prédiction du niveau des nappes phréatiques, le BRGM challenge la communauté francophone

Transcription

Nous allons parler d'intelligence artificielle. Donc, nous sommes en présence de Vincent Labbé et Abel Henriot. Vincent Labbé, vous êtes chercheur à la direction des infrastructures des services numériques. Et Abel Henriot, vous êtes hydrogéologue. Nous allons donc parler data, IA, plein de mots qui font un peu mal à la tête et prédiction des nappes phréatiques. Pour commencer, Vincent Labbé, expliquez-nous ce qu'est l'intelligence artificielle. Bonjour, Élodie. Bonjour à tous. Alors, l'intelligence artificielle, pour le BRGM, c'est avant tout des méthodes numériques qui visent à donner à la machine un comportement intelligent. Dit autrement, en fait, c'est pour permettre d'automatiser des tâches qui étaient trop complexes pour la machine, qui étaient réalisées que par des humains, voire trop complexes même pour être réalisées par un humain. Alors, l'IA, ça a plusieurs sens. C'est une expression qui a d'autres sens. C'est une discipline de l'informatique, bien sûr, avec une communauté très active. Certains disent que c'est révolution technologique majeure. Un "buzzword", mot clé du moment très utile pour gagner des financements. On désigne aussi un programme intelligent comme ça. Mais, quoi qu'il en soit, depuis 10 ans et les succès à répétition du "deep learning", l'IA, c'est devenu la pierre angulaire de la "data science". Alors, qu'est-ce que le deep learning et le rapport entre l'IA et la data science ? La data science, ça désigne 2 choses. C'est l'analyse des données sans hypothèse sur les métiers qui sont derrière les données. Ça ressemble à de la statistique, qui est une des composantes de ce qu'on appelle la data science. Mais il y a une autre composante complémentaire plus empirique et plus opérationnelle. Et c'est précisément la place de l'IA là-dedans. Par exemple, aujourd'hui, les réseaux de neurones profonds, on ne sait pas mathématiquement pourquoi ils fonctionnent aussi bien. Mais on sait empiriquement qu'ils fonctionnent mieux dans certains cas que des techniques plus classiques maîtrisées d'un point de vue théorique. Et le 2d aspect de la data science, c'est le pilotage des organisations par les données. Matthew l'a dit, le volume de données explose dans toutes les organisations aujourd'hui. Les organisations ont bien compris qu'elles pouvaient trouver de la valeur dans ces données en les analysant, parfois en temps réel, pour prendre des décisions. Cette prise de décision, c'est ce qu'on appelle le pilotage par les données. On avait avant... on a toujours d'ailleurs, les dashboards dans les systèmes d'information décisionnels pour aider les décideurs à prendre des décisions. Mais maintenant, on a dans le système d'information opérationnel des décisions qui sont prises automatiquement de plus en plus. Donc, on gagne du temps et on va plus vite.

-Oui.

-Et le deep learning dans tout ça ?

-Le deep learning, c'est une branche de l'apprentissage artificiel qui est au cœur de l'IA. C'est la branche qui engrange le plus de succès depuis 10 ans. C'est pour ça qu'aujourd'hui, tout le monde parle de l'IA. C'est ce qui permet d'extraire de l'information à partir d'images, à partir de textes, ce qu'on appelle les données non structurées. Aujourd'hui, c'est une technologie vraiment clé. Et les entreprises, même les États l'ont bien compris et investissent massivement sur le deep learning et sur l'IA en général. Donc, s'approprier l'IA est aujourd'hui un enjeu crucial ? Alors, oui, c'est crucial, parce que l'IA, c'est ce qui va faire la différence sans doute demain en termes concurrentiels. Les promesses de l'IA, c'est d'apporter de la productivité en automatisant de plus en plus de choses. Ça, c'est... la 1re promesse, et voir monter en qualité ou faire des choses qu'on ne savait pas faire avant. Et, pour le BRGM, en fait, l'IA amène des opportunités et des menaces. Les opportunités, c'est de valoriser des données qui, jusqu'à aujourd'hui, n'étaient pas encore pleinement valorisées. Celles que j'ai évoquées, les images comme des "locks" de forage, des textes comme des rapports du BRGM. C'est aussi passer à l'échelle en termes de prédictivité, être capable d'automatiser la création de modèles prédictifs et de mailler tout un territoire. Ça, ce sont des promesses de l'IA pour le BRGM. Et les menaces, c'est une nouvelle concurrence, en fait, de nouveaux acteurs qui vont rentrer sur les domaines, qui sont plutôt historiques, du BRGM. Parfois, on voit aujourd'hui des acteurs IT informatiques rentrer dans les domaines...

-IT ?

-IT, oui. Information et technologie. Enfin, le domaine numérique. Des acteurs comme Atos, par exemple, rentrer sur des domaines d'application à l'environnement à travers des approches IA. Donc, une nouvelle concurrence se dessine aujourd'hui. Donc, un virage à prendre pour le BRGM, l'IA, incontournable ? Oui, très rapidement, virage à prendre et le BRGM a commencé à le prendre aujourd'hui. Je vais vous citer quelques points rapidement. Aujourd'hui, il y a plus de 40 projets en cours ou à venir dans un avenir proche qui présentent un volet IA au BRGM. Et c'est réparti dans toutes les directions opérationnelles. Il y a une organisation naissante très bottom-up qui s'est créée. C'est un espace Teams complètement ouvert aujourd'hui qui s'appelle "Intelligence artificielle, data science et big data". J'invite tous les intéressés à s'y connecter. Il y a des réunions ouvertes tous les 2 mois. À ma connaissance, il y a au moins 10 data scientists, ou qui peuvent avoir cette casquette, répartis dans les "DO" aujourd'hui, 2 formations qui seront proposées au 2e semestre 2021 et des moyens informatiques, notamment avec l'arrivée du data centre qui vont venir renforcer nos moyens de calcul informatiques pour servir l'IA. Oui, on a bien compris que le BRGM surfe aussi sur la technologie et s'empare de l'intelligence artificielle. Abel Henriot, comment l'intelligence artificielle peut se mettre au service de la prédiction du niveau des nappes phréatiques ? Alors, d'abord, pourquoi on voudrait utiliser l'intelligence artificielle pour vouloir prédire ? Prédire le niveau des nappes souterraines, c'est quelque chose qui est assez ancien. C'est un besoin qui relève du fait de pouvoir se projeter dans l'utilisation des ressources en eau et pour différents usages. On a vu que ça pouvait être important.

-Exactement. Et aujourd'hui, le BRGM sait déjà le faire, mais ne maîtrise pas les techniques qui ont trait à l'IA. Or, on est très en concurrence ou très challengés par nos partenaires ou concurrents dans ces domaines-là. Et si on devait grossir le trait, ça ne revient qu'à faire un lien entre des variables d'entrée et des variables de sortie. Et les algorithmes de l'intelligence artificielle, notamment tout ce qui est la branche des réseaux neurones, est capable de faire ce lien entrée-sortie, avec comme promesse de pouvoir le faire vite et bien, entre guillemets, en tout cas sur des territoires plus vastes et avec moins d'intervention de l'utilisateur, ce qui offre des perspectives assez grandes au BRGM. Et, du coup, dans ce cadre-là, ce qu'on a mis en place dans le cadre du projet exploratoire sur l'IA pour essayer d'atteindre cette cible, de pouvoir simuler le niveau piézométrique à l'aide de l'intelligence artificielle, est basé sur la production d'un banc de test qui vise à comparer et documenter différentes approches pour prédire les niveaux d'eaux souterraines. Les approches classiques du BRGM, mais les approches liées à l'IA, et les évaluer suivant différents prismes. La capacité, par exemple, à récupérer de façon automatique les données, une partie des données, toutes les données, la capacité à exploiter tout ou partie des données, mais aussi la capacité à prédire finement ce qu'attend l'utilisateur final, c'est-à-dire la capacité à reproduire l'évolution dans le temps des niveaux piézométriques. Et ce faisant, on a profité de l'exposition de ce banc de test pour le faire avec des partenaires, notamment dans le cadre de la publication d'un défi avec des partenaires universitaires, l'université de Tours, qui donc prend la forme d'un petit défi qui s'appelle "niña" et qui aura comme point d'arrivée un forum en début janvier 2022, auquel vous serez conviés, bien sûr. Avec plaisir. Eh bien, merci beaucoup. Merci pour cet exposé sur l'avancée numérique au BRGM. Merci beaucoup.

Avancées présentées dans le cadre du programme scientifique "Connaissance des systèmes géologiques".