6 enjeux sociétaux, 14 avancées scientifiques marquantes

Au programme de ce webinaire, 14 projets abordés en 6 vidéos, dans le cadre de nos 6 enjeux scientifiques : géologie et connaissance du sous-sol, gestion des eaux souterraines, risques et aménagement du territoire, ressources minérales et économie circulaire, transition énergétique, données et infrastructures numériques.

Géologie et connaissance du sous-sol

Transcription

On vous retrouve dans l'enjeu géologie et connaissance du sous-sol. Isabelle Thinon, bonjour. Mayotte connaît une crise sismo-volcanique, on en avait parlé l'année dernière, depuis mai 2018, avec la naissance d'un volcan sous-marin. Afin de mieux comprendre ce qui se passe à ce niveau-là, vous êtes partie sur un bateau, le Pourquoi Pas, pendant 55 jours l'année dernière. C'était une expérience riche dont vous allez pouvoir nous parler tout de suite. Vous êtes partie 55 jours ?

Oui, tout à fait.

Pourquoi partir aussi longtemps ?

La 1re chose, c'est que la crise sismique de Mayotte, qui a débuté en mai 2018, a eu de nombreuses interrogations scientifiques, comme : quelle est la géologie au large de Mayotte ? Quelle est la géologie du socle ? Quel est le contexte géodynamique régional ? Et y a-t-il d'autres aléas possibles ? On s'est aperçus que c'était une région très peu investiguée avec très peu de données disponibles et beaucoup d'hypothèses, et certaines contradictoires. En septembre 2018, le BRGM et des collaborateurs académiques ont soumis une proposition de campagne à la mer, océanographique, de recherches pour lesquelles on a fait de l'acquisition pendant 55 jours. Et donc... avec les agents BRGM, il y avait une trentaine de scientifiques de différents organismes, de différents laboratoires, français, allemand, de l'Union des Comores, et puis 6 étudiants dont 5 en thèse nous ont accompagnés et 2 professeurs de lycée SVT du rectorat de Mayotte, justement, pour la pédagogie. Voilà. Durant cette campagne Sismaoré, on a exploré 80 000 km2 dont 60 000 autour de l'archipel des Comores qui est composée de 4 îles volcaniques : Grande Comore, Anjouan, Mohéli et Mayotte.

Cette campagne, j'ai envie de dire cette aventure, a permis de collecter de nombreuses et précieuses données. Quelles sont-elles ?

Il y a un petit film qui passe. Il y a 3 sets de données. La 1re concerne la cartographie du fond marin. Ce sont des données géophysiques, des données bathymétriques qui nous donnent la profondeur et la morphologie du fond marin. Des données de réflectivité qui nous apportent une nature. C'est là où on peut identifier des coulées de lave, par exemple. Et puis, nous avons aussi eu des données d'acoustique de colonne d'eau pour voir s'il y avait d'autres éruptions, en cours ou pas. Cette cartographie du fond marin nous a permis d'identifier plus de 2 200 édifices volcaniques, des petits, mais qui atteignent quand même 600 m de haut, des coulées de lave, des failles. Nous avons aussi identifié deux champs volcaniques entre 2 000 et 5 000 km2 de superficie.

Sacrée aventure !

L'autre set de données, ce sont des données géophysiques, d'autres données géophysiques, mais qui nous renseignent sur le sous-sol. Donc nous avons plus de 10 000 km de ce qu'on appelle nous sondeurs de sédiments, c'est de la très haute résolution qui nous donne l'architecture des premiers dizaines de mètres de sédiments. Nous avons des données de sismique réflexion haute résolution et de sismique longue écoute. Par exemple, un profil sismique a été effectué sur le nouveau volcan en éruption, en activité. Et donc, ça nous permet d'avoir une image, une coupe comme un millefeuille, de l'architecture de ce volcan et de son substratum. On sait maintenant qu'il repose sur une couverture sédimentaire et sur un socle. Ça, c'est le travail d'un étudiant en thèse.

Justement, vous en parlez. Ça va nourrir énormément de données, et des thèses sont en cours.

Oui. En fait, il y a d'autres données, des données de réfraction, des flux de chaleur, du magnétisme à granulométrie et des prélèvements de roches et de sédiments pour nous permettre de dater et d'avoir la nature et donc l'origine. Effectivement, toutes ces données sont... Il y a de très grosses données très diversifiées, et donc il faut les interpréter, enfin, avant tout les analyser, les traiter. Nous avons la chance d'avoir un projet que l'on appelle Coyote, financé par l'ANR. Il nous permet de financer 3 thèses, un post-doc, des masters et aussi de fédérer une communauté scientifique d'une quarantaine de personnes autour de ces sujets. L'objectif final de cet ANR Coyote, c'est d'apporter une connaissance, d'améliorer la connaissance géologique de ce territoire, tout ça pour mieux contraindre les aléas possibles de cette région.

Merci beaucoup et bravo pour cette belle aventure. Là, on va quitter le Mozambique et on va se rendre en Afrique avec Yannick Callec. Bonjour.

Bonjour.

Vous avez participé à la réalisation d'un référentiel qui intègre la géologie africaine. Pouvez-vous nous expliquer de quoi il retourne ?

Oui, merci. Au vu du contexte international avec des tensions croissantes sur l'approvisionnement en ressources, en particulier en lien avec les révolutions technologiques et énergétiques, et on le voit aujourd'hui, en lien avec les tensions géopolitiques. Le BRGM a considéré comme pertinent et nécessaire, dès 2020, de développer un programme concernant la caractérisation, enfin, l'établissement d'un référentiel géologique et des ressources stratégiques sur le continent africain. C'est un programme coordonné par Florence Cagnard, qui est absente aujourd'hui, mais je la représente. Vous allez me dire : pourquoi l'Afrique ? Le BRGM bénéficie de plus de 70 ans d'expérience sur le continent africain, à la fois concernant les problèmes de cartographie géologique et d'exploration minière. D'autre part, ce qui est important, c'est que l'Afrique, c'est 20 % des terres émergées, mais c'est seulement 13 % des budgets d'exploration minière à l'échelle mondiale. Donc il y a des potentiels importants avec vraisemblablement une sous-évaluation des potentiels miniers. En lien avec les révolutions technologiques et énergétiques dont je parlais tout à l'heure, des ressources métalliques qui étaient considérées comme secondaires deviennent maintenant d'importance stratégique. Des gisements à faible concentration deviennent des gisements à forte valeur ajoutée. C'est dans cette optique-là que ce projet a été initié. Ce projet, il s'articule autour de deux grands volets qui concernent la bancarisation et la capitalisation des données existantes du BRGM. Je disais tout à l'heure qu'on avait une expérience de près de 70 ans. Vous imaginez le volume de données en termes de rapports, de bases de données, de cartes, à toutes les échelles, du 10/1 000 000 au 25/1 000. Et d'autre part, un autre volet concerne les aspects de recherche afin d'identifier les critères de favorabilité pour typer les gisements, à la fois en termes de potentialité, mais aussi en termes de processus, pour évaluer quels sont les processus géologiques favorables à l'émergence ou au développement d'un gisement d'importance. Vous avez ici une carte élaborée par Mathieu Chevillard de DGR qui reflète la répartition spatiale des indices miniers, enfin, des ressources minières. On n'a sélectionné que les éléments considérés comme stratégiques par la Commission européenne en 2020. Les symboles représentent la diversité des substances et leur taille représentent l'importance du gisement. Donc on voit qu'on a une répartition différenciée et vraisemblablement des zones qui sont sous-explorées. Ce qu'il faut également comprendre, c'est que l'idée, c'est d'intégrer nos différents projets acquis précédemment et en cours, comme l'a présenté Pierre, avec les projets récents sur le Malawi et sur le Cameroun. On produit des éléments cartographiques à différentes échelles, et toute la problématique, c'est de pouvoir les intégrer dans un même référentiel. Pour ça, il faut qu'on développe des référentiels communs et des standards permettant d'uniformiser l'information géologique et minière.

Vous consolidez ce référentiel.

On le consolide parce qu'on ne part pas de rien. Le BRGM a une longue expérience d'explorateur. En fait, on reprend un programme qui a été piloté par Jean-Pierre Milesi de la fin des années 90 à 2004 qui s'appelait SIGAfrique. Là, on reprend ce programme-là. C'est un peu une renaissance. On essaie de capitaliser l'ensemble des projets cartographiques et des projets miniers qu'on a réalisés depuis 2000, ce qui fait à peu près 20 ans de projets qu'on doit réintégrer dans un même référentiel qu'on doit standardiser et qu'on doit réintégrer en termes de compréhension pour s'approprier les éléments et les résultats principaux de ces programmes. Ça, c'est sur l'aspect du 1er volet de bancarisation et de valorisation des données. Sur l'aspect recherche, l'idée, je le disais tout à l'heure, c'est qu'on cherche à discriminer les paramètres favorables à la genèse d'une métalothèque. Ces paramètres, c'est à la fois au niveau structural, au niveau chronologique et au niveau des conditions de pression de température qui permettent la migration des fluides favorables au développement d'un gisement. On ne peut pas aller chercher tous les cailloux pour chaque centimètre carré. L'idée est de déployer des modèles de prédictibilité dont Blandine nous parlera tout à l'heure dans l'autre axe programmatique et de les déployer à l'échelle continentale sur le continent africain.

Ce sera une passerelle vers d'autres projets.

C'est ça. L'idée est d'accompagner le démarchage, à la fois l'appui aux politiques publiques des États concernés, de la diplomatie des ressources de l'État français, et de la politique européenne en appui au projet AfricaMaVal, dont a parlé Christophe tout à l'heure.

Merci beaucoup à tous les trois d'être venus nous présenter cet enjeu géologie et connaissance du sous-sol. Beaucoup de choses sont faites et sont encore à faire. Bravo et bonne continuation.

Gestion des eaux souterraines

Transcription

Nous attaquons tout de suite avec l'enjeu de la gestion des eaux souterraines. Pour cela, on accueille Benoit Vittecoq en visio et en direct de la Martinique. Bonjour, Benoit.

Bonjour. Bonjour à tous.

On est connectés, donc tout va bien. Vous, vous étudiez la perméabilité des aquifères liée à la sismicité. Pouvez-vous nous expliquer ce que c'est, précisément ?

Oui, effectivement, mon travail de recherche s'intéresse à l'impact de la sismicité sur l'évolution de la perméabilité des aquifères volcaniques. Pour rappel, la perméabilité en hydrogéologie, ça correspond à la vitesse de circulation de l'eau dans les nappes souterraines. Donc, dans les contextes géologiques volcaniques, il est généralement considéré que la perméabilité des aquifères diminue avec le temps, en raison de l'altération des roches due, comme vous en parliez, au climat tropical, et aux circulations de fluides hydrothermaux étant donné que nous sommes sur des volcans. Donc, un premier travail de synthèse de l'ensemble des mesures de perméabilité dans des forages réalisés en Martinique, a mis en évidence que cette hypothèse de diminution, dans le temps, de la perméabilité, n'était pas démontrée et, qu'à l'inverse, nous observions une augmentation significative de la perméabilité, donc de la vitesse de circulation de l'eau souterraine, au cours des temps géologiques, sur environ 15 millions d'années.

Qu'est-ce qui pourrait expliquer, justement, cette différence ?

Alors, l'hypothèse que nous avons formulée, c'est que la Martinique étant située dans une zone sismique, des séismes de fortes magnitudes, qui sont heureusement rares à l'échelle humaine, mais très fréquents sur une durée de plusieurs milliers ou millions d'années, que ces séismes pouvaient fissurer et fracturer régulièrement les aquifères, et augmenter ainsi leur perméabilité. Donc, afin de vérifier cette hypothèse, nous avons développé une méthodologie originale en travaillant sur les données d'un forage que j'avais équipé en 2005, et qui enregistre les variations du niveau de la nappe, toutes les heures. Ce forage présente, parmi ses particularités, des oscillations de son niveau d'eau, deux fois par jour, qui sont induites par l'attraction de la Lune. Ce phénomène est assez similaire aux marées océaniques qui sont observées sur les côtes ou dans les ports. L'écorce terrestre, également, est sensible à ces variations de gravité, mais ces variations sont nettement plus faibles et, dans les forages, sont de l'ordre de quelques centimètres. Donc, étant donné qu'on connaît les positions respectives de la Terre et de la Lune, l'amplitude d'une marée terrestre peut être calculée à chaque instant. Notre méthode a consisté à calculer, sur une quinzaine d'années, le décalage entre les ondes de marées terrestres et les oscillations du niveau d'eau observées dans ce forage.

Quelles sont les principaux résultats obtenus ?

Ce qui ressort de notre travail est assez remarquable. Pour chacun des 5 plus gros séismes qui se sont produits à proximité de la Martinique entre 2005 et 2020, une modification significative du décalage, de ce décalage, est observée. Et, grâce à quelques équations, il est possible de calculer la perméabilité d'un aquifère et de démontrer ainsi une augmentation de sa perméabilité sur la période étudiée. Nous avons aussi démontré, comme l'expliquait Dominique, que les événements extrêmes, comme les ouragans ou les très fortes zones tropicales qui passent régulièrement sur l'île, entraînent, quant à eux, une augmentation provisoire de la perméabilité en provoquant une sorte de nettoyage des fissures et des fractures des aquifères.

Quel est le but de ces démonstrations ?

Ce travail permet, tout d'abord, d'un point de vue opérationnel, d'aider les hydrogéologues lors de prospections, quand ils réalisent des forages pour alimenter en eau la population. Quand ils travaillent dans des secteurs volcaniques ou à forte sismicité, nos travaux montrent que les aquifères anciens qui étaient souvent écartés, car considérés comme peu perméables, sont des cibles particulièrement intéressantes. Nos travaux, aussi, permettent de mieux appréhender l'évolution de la perméabilité, de la vulnérabilité des aquifères, en particulier vis-à-vis des transferts de pesticides qui pourraient évoluer si les vitesses de circulation peuvent augmenter dans le temps. Enfin, la méthode que nous avons développée, de calcul de la perméabilité à partir de l'analyse des ondes de marées terrestres pourrait aussi être déployable à d'autres sites.

Ce qui ferait de la Martinique un site pilote ?

Effectivement, les premiers développements méthodologiques sur les calculs de déphasage réalisés en Martinique sont très prometteurs. Suite à la première publication de nos travaux, une nouvelle thèse, financée par l'Ecole normale supérieure de Paris, a été initiée en partenariat avec le BRGM. Et un projet de recherche dédié est mis en place pour continuer à mieux caractériser ces phénomènes, développer les équations et, ensuite, pouvoir déployer l'approche à d'autres territoires.

Merci beaucoup, Benoit. Bon courage à vous, bonne continuation et profitez bien du soleil, on en manque.

À bientôt.

Merci.

On revient sur le plateau. Anne Togola, bonjour. On en parlait tout à l'heure, il y a la qualité de l'eau. Et vous, vous travaillez sur de nouveaux outils de mesures, sous deux axes, que vous allez nous expliquer.

Bonjour. Nous, on travaille, en effet, sur deux grands axes de recherche sur le volet "qualité des eaux". C'est, à la fois, les mesures d'échantillonnage, donc la manière de prélever l'eau dans les milieux, pour être plus représentatif, mais aussi comment améliorer l'analyse et qu'est-ce qu'on va mesurer. Là, on travaille sur de nouveaux outils, notamment pour le screening non-ciblé, et qui vont utiliser de nouveaux équipements, basés sur la spectrométrie de masse haute résolution.

Spectrométrie de masse haute résolution ?

C'est un outil qui nous permet de mesurer et d'identifier les molécules et les composés présents dans l'eau par rapport à leur structure chimique. Nos objectifs, c'est de rechercher et d'identifier de nouvelles molécules d'intérêt pour répondre à l'enjeu d'une meilleure connaissance des milieux et mieux mesurer ce qui est réellement présent dans les milieux naturels. Donc, ces deux axes alimentent les thématiques du BRGM à travers deux grands volets qui sont notre expertise. À la fois la partie analytique, mais aussi la capacité de transfert de ces polluants vers l'environnement souterrain qui nous intéresse. Donc, nous, on s'est intéressés ici, à travers deux projets un peu phares sur 2021... Un projet qui est une grande action de démonstration à large échelle, sur le territoire national, sur l'utilisation d'échantillonneurs passifs. Ce sont des outils. J'en ai amené un.

Je me demandais ce que c'était.

On les voit aussi à l'écran. La manière dont on les déploie. Ces systèmes nous permettent de capter les molécules présentes dans l'eau et de ramener au laboratoire un échantillon représentatif du milieu naturel. Ce projet national s'est déployé sur 3 ans, jusqu'à 2021, et un autre exemple de projet, plus axé sur les molécules d'intérêt, on peut parler du projet axé, qui était focalisé sur l'identification de nouvelles molécules, des métabolites de pesticides. On travaille sur les pesticides, mais dans le milieu, ils vont se dégrader. On a besoin d'améliorer la connaissance sur ces molécules, c'est le projet axé. Ou sur une thématique phare depuis quelques années : les bisphénols. On a entendu parler du bisphénol A. Il n'est pas tout seul. Il est accompagné. Il est remplacé actuellement par le bisphénol S. Une quinzaine de molécules peuvent être utilisées pour la substitution. L'intérêt est de savoir si ces molécules sont déjà présentes dans les milieux. Et il y a un volet toxicité, pour connaître leurs effets, traité par nos partenaires.

Vos recherches s'inscrivent dans l'appui aux politiques publiques.

Tout à fait. On développe de nouvelles approches pour mieux mesurer et savoir ce qui est présent dans les milieux. Notre intérêt est de décliner ces découvertes, ces avancées scientifiques, vers la réglementation. Donc, de venir alimenter la surveillance réglementaire en proposant de nouvelles molécules ou de nouvelles techniques pour mieux les mesurer. Ces actions, certes, c'est la politique nationale et internationale mais on vient, aussi, beaucoup en appui au niveau régional et aux collectivités. Là, on s'appuie fortement sur nos interactions avec les directions territoriales qui sont en lien direct avec les acteurs locaux. Quand on parle de qualité des eaux, on parlait d'échantillonnage passif, un exemple de déclinaison opérationnelle où l'on est allés jusqu'au bout, c'est qu'on attend impatiemment la sortie du dernier arrêté de surveillance, c'est l'outil qui va permettre de décliner la directive cadre sur l'eau au niveau national, et dans laquelle on a réussi à faire inscrire des nouvelles molécules qui sont issues de travaux anciens du BRGM. Mais aussi l'utilisation de ces nouveaux outils. Pour nous, c'est un vrai succès. On est vraiment allés de la partie recherche assez fondamentale, jusqu'à la déclinaison et jusqu'au travail avec les acteurs pour transférer notre savoir vers les opérationnels sur le terrain.

Du concret, quoi.

Du concret.

Vous parlez de contaminant. On a parlé tout à l'heure avec Dominique Darmendrail, des polluants émergents, De quoi on parle ?

Alors, le terme émergent... L'idée, c'est que ce sont des molécules qui ne sont pas encore dans les réglementations. Ce sont les molécules pour lesquelles on a peu d'informations.

Elles sont nouvelles ?

Pas forcément. C'est la grande difficulté. On parle des pesticides. Je vous parlais, tout à l'heure, des métabolites de pesticides. On connaît les parents, mais pas les produits de dégradation. On va parler des produits pharmaceutiques. Et on va parler de molécules naturelles, type les hormones. Elles ont des effets qu'on n'attendait pas sur l'environnement.

Les hormones, on les retrouve ?

Dans l'environnement. Elles peuvent avoir des effets sur les écosystèmes. Elles n'étaient pas réglementées, mais on se pose des questions. Elles font partie de la grande classe appelée "les polluants émergents". Ces molécules, on va les retrouver. Elles sont émises dans l'environnement suite aux activités humaines, quelles qu'elles soient. On parle d'agriculture, de l'industrie et de notre quotidien. On a une famille appelée care products. Ce sont celles liées à nos usages du quotidien. Les filtres UV... On va retrouver les médicaments, la caféine, très présente dans les milieux. C'est notre quotidien et notre manière de consommer certains produits qui créent cette problématique.. Tout à l'heure, on parlait des PFAS, des composés perfluorés. Ce sont des composés présents dans absolument tous les usages qu'on peut avoir. Du plus domestique, les revêtements anti-adhésif des poêles, par exemple, jusqu'au revêtement des canapés. On les retrouve partout. Et maintenant, c'est une vraie thématique, une problématique dans l'environnement. On parlait du projet PROMISCES, un projet européen, qui sera focalisé sur ces thématiques.

À bon entendeur. On ne pensait pas avoir autant d'effets. Merci beaucoup, en tout cas. Ça nous éclaire sur tout ce qui va arriver, tout ce qu'on découvre aussi et qu'on a besoin de découvrir pour prendre un peu soin de notre eau qui va tant nous manquer. Merci beaucoup, mesdames.

Risques et aménagement du territoire

Transcription

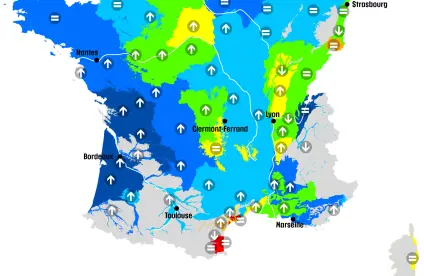

Bonjour. Vous travaillez sur les matériaux lourds, les hydrocarbures notamment, et de leur dépollution. De quoi il retourne ? Oui, tout à fait. Nos travaux de recherche portent sur la dépollution des sites et sols pollués. Déjà, pourquoi est-ce qu'on va dépolluer des sites et sols pollués ? Parce qu'il va falloir pouvoir avoir de l'eau potable dans les eaux souterraines, reconstruire des friches, reconstruire sur des friches urbaines des quartiers dits résidentiels ou autre chose. Il y a plein de techniques de dépollution qui existent. Il y a des techniques qui sont basées sur des appuis thermiques. On va chauffer des sols, pomper l'eau. Ça va être des phénomènes physiques. On va utiliser des procédés chimiques en utilisant certains additifs, des oxydants, des choses comme ça. Aussi, des procédés biologiques. Et là, on va utiliser des bactéries. Et tous ces procédés, quand on veut les appliquer dans les sols in situ, on a un gros souci, c'est-à-dire qu'on va avoir un problème d'homogénéité de la dépollution puisque les sols sont, par définition, hétérogènes. Il y a des perméabilités différentes. La question, c'est : comment on peut arriver à dépolluer de manière homogène des sols hétérogènes ? Et donc, on va prendre un exemple. Typiquement, une technique de dépollution chimique. Qu'est-ce qui va se passer ? On va utiliser, typiquement, on va dire des surfactants, donc c'est comme du liquide vaisselle. Si on injecte ces liquides vaisselle dans des sols qui sont plus ou moins perméables, ces liquides... C'est des produits biodégradables, bien entendu. ...ont pour but de désorber les polluants des sols. Donc, si on les injecte dans des couches perméables, ça va passer à travers assez facilement et si, à côté de ces couches perméables, on a des couches un peu moins perméables, on aura de très grandes difficultés à injecter notre produit dans les couches très peu perméables. Donc il va y avoir des écoulements préférentiels dans les couches perméables. Pour contrecarrer ça, on a mis au point des techniques de dépollution basées sur ce que l'on appelle des liquides non-newtoniens. Des liquides non-newtoniens, c'est... Prenez l'exemple, typiquement, de la mayonnaise. Quand vous remuez votre mayonnaise avec une cuillère, vous allez avoir la viscosité de la mayonnaise qui va changer en fonction de la vitesse à laquelle vous remuez la mayonnaise. Donc, la viscosité dépend des contraintes que l'on impose sur ces liquides. Donc, sur la base de ces constats, on a utilisé des liquides non-newtoniens gel ou mousse, dont la viscosité diminue en fonction de la force que l'on met dessus. Ça veut dire que si l'on prend notre exemple avec notre surfactant, notre liquide vaisselle, si on le combine avec un liquide non-newtonien, avec des sols perméables à côté de sols moins perméables, dans les couches perméables, on va avoir une viscosité où on n'a pas besoin de forcer énormément pour que le liquide rentre, donc notre liquide non-newtonien et notre surfactant, donc on va forcer très peu, la viscosité sera importante. Dans les parties un peu moins perméables, on va être obligés de forcer plus. La viscosité va être diminuée. On se rend compte que la viscosité va dépendre de la perméabilité. En jouant sur ces propriétés de liquides non-newtoniens, on va être capable de balayer de manière extrêmement homogène tous les sols qui sont hétérogènes. Donc ça augmente les rendements épuratoires. Et donc, on utilise ces liquides pour, on va dire, pousser des produits purs, pour vectoriser différentes choses, des additifs... Et tout ceci, on met tout ça au point dans une plateforme qu'on appelle la plateforme PRIME. - En laboratoire. - En laboratoire, oui. Et cette plateforme PRIME... Alors, elle est très importante pour nous parce que ça nous permet de voir à différentes échelles ce qui se passe. Ça nous permet de mettre au point des techniques de monitoring, de modélisation ou de mise au point de procédés de dépollution. Si on vient à la dépollution, typiquement, on va travailler d'abord à des petites échelles, dans des fioles, des choses comme ça. Et puis, après, on va augmenter l'échelle, la taille, on va dire des expériences que l'on fait. On va aller dans des colonnes, dans des bacs de quelques centimètres on va dire et on va finir sur des choses de plusieurs litres voire, à la fin, sur une plateforme plurimétrique, un pilote plurimétrique qui fait 160 m3. Sur cette plateforme, on est capable d'utiliser toutes ces échelles et puis, donc, de travailler en 1D, 2D, 3D. Ça veut dire qu'en laboratoire, vous retrouvez toutes les situations qu'on peut avoir en site naturel ? L'idée, c'est ça, c'est de complexifier les choses et de se rapprocher le plus possible de ce qu'on va retrouver sur le terrain. Et pour extrapoler ce qu'on va faire sur le terrain plus tard, on arrive avec le PPM à être très proche de ce qu'il y a sur le terrain, on va utiliser des modèles et ces modèles vont nous permettre, basé sur des changements d'échelle, de prédire ce qui va se passer sur le terrain. et aussi de voir ce qu'il est possible de faire dans d'autres conditions, de se mettre dans d'autres situations. Et on modélise tout ça avec des techniques d'interprétation d'images et des techniques géophysiques. On va injecter du courant dans les sols pour pouvoir bien voir tout ce qui se passe dans les sols, comment notre procédé bouge en fonction du temps, si on a bien injecté notre pollution... D'ailleurs, il y a un brevet sur ces techniques de couplage d'images et de techniques géophysiques qui a été déposé. Merci beaucoup. Et félicitations pour ce brevet et cette avancée remarquable de 2021. Là, je vais avoir Samuel Auclair. Bonjour, Samuel. Vous allez nous parler des outils de gestion de crise et d'estimation rapide des dommages en cas de séisme. De quoi il s'agit ? Après un séisme... C'est un phénomène qui est imprévisible et du coup, qui surprend tout le monde. En 1er lieu les autorités qui ont en charge la gestion des risques. Il convient de leur donner rapidement des informations sur l'ampleur de l'intensité du phénomène et de ses conséquences. Jusqu'à maintenant, ce qu'on faisait, c'est qu'on faisait une estimation rapide de l'intensité des secousses basée uniquement sur les mesures des sismomètres couplée avec des modèles notamment pour prendre en compte des amplifications locales liées à des spécificités soit topographiques, soit géologiques. Ce sur quoi on a travaillé ces dernières années au BRGM, c'est sur la prise en compte d'autres capteurs, notamment les capteurs sociaux, et en l'occurrence, des données venant des réseaux sociaux et de Twitter en particulier. Ce qui se passe, c'est qu'après un séisme, beaucoup de personnes sautent sur leur téléphone pour témoigner de ce qu'ils viennent de ressentir. Tout ça, ça peut être capté en temps réel de manière automatique et peut nous permettre d'être vu comme un capteur et de nous aider à calibrer nos cartes d'intensité des secousses. Cette année, dans le cadre d'un projet européen qui s'appelait TURNkey, on a pu, justement, travailler sur cette fusion de données, de données complètement différentes, des capteurs physiques d'une part, technologiques, et d'autre part de capteurs sociaux, et de coupler cela avec d'une part une mesure qui est très qualifiée, très précise, celle du capteur technique, mais où on en a peu, les sismomètres, en France, ça se compte en centaines, pas en millions, et de coupler cela avec des mesures plus imprécises, plus imparfaites, mais beaucoup plus nombreuses. Et donc, on a une évidence dure d'une part, une évidence que l'on va appeler "molle" de l'autre, et on a été capable de le coupler avec des techniques dites de réseaux bayésiens de sorte à mieux calibrer ces cartes. Les résultats montrent que ça permet un incrément de fiabilité. Mais ça, il faut savoir que c'est très important parce que si on est capable de mieux estimer, quand je dis en temps réel, c'est en quelques minutes après la survenue d'un séisme, si on est capable de mieux qualifier l'intensité des secousses, derrière, on est capable de mieux prédire les pertes associées. Vous parliez des réseaux sociaux, donc de Twitter, les tweets que vous récupérez et qui permettent d'avoir cette donnée en temps réel, aussi molle soit-elle, et notamment qui fait partie d'un projet, Suricate-Nat. Effectivement, nous avions déjà, depuis 2016, mis en place une plateforme avec l'appui de la fondation MAIF pour monitorer ces réseaux sociaux, Twitter en l'occurrence. Ça, c'était la 1re étape. C'était constituer le capteur, être en capacité de l'écouter, de l'analyser, de faire des 1res analyses, des 1ers filtrages, mais derrière, la question était de voir comment la valoriser. Donc là, effectivement, ce qu'on a fait cette année, c'est qu'on a utilisé ce capteur, cette plateforme Suricate-Nat pour mieux calibrer nos cartes. Vous êtes sismologue. Vous nous avez parlé de séismes, mais ce ne sont pas les seuls aléas que vous étudiez. Effectivement. Je disais que le séisme avait la particularité de ne pas être prévisible, et du coup, on est là en réaction. - Plutôt qu'en anticipation. - Exactement. En réponse rapide pour estimer rapidement l'ampleur des secousses. Pour d'autres phénomènes tels que les phénomènes hydroclimatiques, on peut penser aux cyclones, aux tempêtes, aux tsunamis, là, l'enjeu est de prédire avant que les effets ne surviennent. L'établissement BRGM travaille beaucoup sur ces sujets-là. Par contre, les problématiques scientifiques sont tout autre. Là, la difficulté, c'est qu'on a des modèles qui marchent relativement bien quand on a du temps devant nous pour faire tourner ces modèles, mais par contre, ces modèles sont lourds à faire tourner et le temps de propagation de ces phénomènes est tel qu'on n'a pas le temps, finalement, de mettre à profit nos capacités de modélisation. L'approche qui est adoptée, c'est de modéliser le modèle. C'est de faire des métamodèles qui sont beaucoup plus rapides dans le temps de calcul et qui peuvent permettre d'être compatibles avec un temps pour apporter une réponse à une autorité, à une préfecture, à des pompiers par exemple. Et puis être, du coup, plus réactifs et plus efficaces au quotidien. Tout à fait. Merci beaucoup pour ces explications et bravo pour cette avancée. Je vais donner la parole à Marc Peruzetto, bonjour. Dans le cadre de la prévention des risques de glissement de terrain, on parlait tout à l'heure des coulées de boue, vous avez réalisé une étude durant l'année 2021. Pouvez-vous nous en parler ? Oui. C'est une étude qui fait partie d'un projet plus important mené par le BRGM Martinique. à la demande de la DIREN Martinique. L'objet de l'étude, c'était d'analyser les risques associés à des coulées de boue dans une rivière qui s'appelle la rivière du Prêcheur. Cette rivière est située au nord de la Martinique, sur les versants de la montagne Pelée. Et à sa source, il y a une falaise qui s'appelle la falaise Samperre, et qui, depuis une cinquantaine d'années, régulièrement, s'effondre. Le problème, c'est que quand il y a ces effondrements, il y a un stock de matériaux, de sable, de blocs, au pied de la falaise qui se forme. Ces matériaux-là, typiquement quand il pleut, ils peuvent être remobilisés par l'eau et ça, ça génère des coulées de boue, des coulées de débris qui se propagent dans la rivière. Ces coulées sont dangereuses pour le village qui est à l'embouchure de la rivière, qui s'appelle le village du Prêcheur. Il y a 2 risques principaux. Le 1er, c'est le risque de débordement. Ça s'est déjà produit, par exemple en 2010. La coulée de boue peut déborder de la rivière et aller impacter des bâtiments et, évidemment, menacer les habitants. Il y a aussi un risque au niveau des infrastructures. Le pont qui traverse la rivière peut être détruit et s'il est détruit, tous les habitants qui habitent sur la rive nord de la rivière sont coupés du reste du monde, il n'y a plus de route. - Il n'y a plus d'autre accès ? - Exactement. L'objectif du projet, c'était d'essayer de mieux quantifier ces risques à l'aide de simulations numériques. C'est ce qu'on a fait en collaboration avec l'Institut de physique du globe de Paris. en utilisant un modèle qui s'appelle Chaltop et qui permet de modéliser la dynamique et la propagation de ces coulées de boue, de ces coulées de débris. Il y a 2 points importants à retenir sur l'utilisation de ces outils. Exactement. Le 1er point à avoir en tête, c'est qu'avant de se lancer dans des simulations, il faut savoir ce qu'on simule, être confiant dans les simulations. La 1re étape avant de faire des simulations, c'est d'aller sur le terrain et de récolter des données de nature très variée. C'est ce qu'on a fait. Des données topographiques, des analyses d'échantillons qui ont été récupérés dans la rivière... Et ces données-là, elles permettent d'abord de bien choisir les paramètres qui vont être utilisés dans les simulations et des paramètres qui vont contrôler la dynamique de l'écoulement, s'il est plus rapide, s'il est moins rapide. Ces données permettent aussi de choisir des scénarios de simulation, typiquement en termes de volume de coulée de débris, qui sont réalistes au regard de ce qui s'est déjà passé dans la rivière. C'est le 1er point. Le 2e point, c'est, une fois qu'on a fait cette étape où on est assez confiants sur les simulations et sur ce qu'on simule, on peut utiliser les résultats des simulations pour mieux quantifier la vulnérabilité du village. Ce qu'on a fait, c'est toute une batterie de simulations en simulant des coulées de débris avec des volumes plus ou moins importants, avec des mobilités plus ou moins importantes. En faisant varier, aussi, la géométrie du lit de la rivière. Par exemple en mettant un ouvrage de protection sur une rive. Et voir dans ces différentes situations quel est l'impact sur la vulnérabilité, quel est, typiquement, le nombre de bâtiments qui va être impacté. Ça, en termes opérationnels, c'est évidemment intéressant pour les décideurs et les acteurs. Pour explorer cette zone, vous avez pris les airs. C'est ça. En 2022, pardon, 2021, pendant une mission que j'ai réalisée sur place, on a fait un survol hélicoptère avec la Sécurité civile. Ce survol a permis... J'ai parlé tout à l'heure de la récupération de données. On a pris plein de photos de la rivière, ce qui est en train d'être projeté, et ces photos permettent de reconstruire un modèle photogrammétrique en 3D de... là, ce que vous voyez, c'est la partie amont de la rivière. C'est très important parce que ça permet de faire un état des lieux à une date T de cette partie amont où les coulées de boue sont générées. Et en particulier, d'estimer le volume de matériaux qui est disponible et qui peut être remobilisé lors d'une coulée de boue. Vous vous êtes installé en Martinique pour pouvoir mener votre étude dans l'année ? Non, je suis resté basé en métropole, mais j'ai fait 2 missions de 3 semaines, une 1re en 2019 pendant ma thèse où j'avais déjà commencé à travailler sur ce sujet-là, et une 2e mission, donc en 2021, là où on a fait le modèle photogrammétrique. Et donc, ces 2 missions, elles ont permis, sur les 2 points, d'une part d'aller sur le terrain voir ce qui se passe et essayer de comprendre, voir avec mes yeux ce que je modélisais, récupérer des données. Et puis, aussi, évidemment, échanger avec tous les acteurs impliqués. Le BRGM Martinique, la DIREN Martinique aussi, et puis, des échanges, aussi, avec l'Observatoire volcanologique et sismologique de la montagne Pelée, qui est géré par l'IPG, qui a participé aussi à ce projet-là. Est-ce que cette étude est terminée ? Oui, elle est terminée. Il y a un rapport qui a été rendu à la DIREN. Il y a encore une présentation qui doit être faite à l'oral, il y a encore des choses à faire, mais l'étude est terminée. Merci beaucoup et bravo. Une belle avancée. Et merci de nous avoir projeté cette animation qui nous permet de bien nous rendre compte. Merci à tous, messieurs, de nous avoir présenté cet enjeu au travers de vos travaux.

Ressources minérales et économie circulaire

Transcription

On va tout de suite parler avec Blandine Gourcerol. Bonjour. Nous venons de le voir, les métaux sont de plus en plus spécifiques avec un panel aussi de plus en plus important. Pour répondre à cet enjeu, vous, vous élaborez des cartes prédictives.

Tout à fait. La prédictivité, c'est un outil qui est développé au sein du BRGM depuis plusieurs années. Aujourd'hui, on a deux gros projets, dont un qui vient de se finaliser, FRAME, qui est un projet GeoERA.

GeoERA ?

GeoERA, c'est... Commission européenne, qui est financé par le programme H2020, et qui regroupait une vingtaine de partenaires. Et le BRGM, notamment avec la participation d'Eric Gloaguen et de Guillaume Bertrand, ont participé à sa réalisation. Et le but de ce projet était de mettre en avant des zones favorables pour la découverte de nouveaux gisements, pour 7 substances incluant le lithium, le cobalt, les terres rares, les phosphates, le niobium, le tantale et... j'en oublie un...

On les retiendra pas, c'est pas grave. Mais ils sont nombreux !

Ce projet avait pour but, à l'échelle européenne, de pouvoir établir des zones de prédictivité, favorabilité pour ces métaux en utilisant la méthode CBA, qui est la méthode cell-based association, qui est développée par le BRGM et qui permet de pouvoir s'affranchir de certains manques d'informations sur certains contours géologiques. Et de pouvoir également se baser sur la lithostratigraphie dans lequel ces gisements... dans les unités géologiques dans lesquelles ces gisements peuvent se retrouver. Donc, ça, c'est la méthode CBA qui a été... pour FRAME. En parallèle, nous avons un nouveau projet qui s'appelle ION4RAW, qui est également un projet financé par le programme H2020, qui avait, ou qui a pour but, puisqu'il est en cours depuis 2019, de traiter les minerais issus des mines d'or, d'argent et de cuivre pour en obtenir et en extraire, au mieux, les petits métaux, c'est-à-dire les métaux comme le gallium, le germanium, l'indium, le tellure, les métaux qui ne sont pas forcément utilisés ou extraits lors des traitements actuels. Une des étapes de ce projet, initialement, a été de définir des zones où l'on pouvait, en Europe, rechercher ces métaux puisque ces métaux ne sont pas forcément identifiés dans l'ensemble des bases de données européennes. Et donc pour se faire, on a utilisé une nouvelle méthode, qui est la méthode DBQ, également développée au sein du BRGM, qui permet d'augmenter le taux de probabilité et d'informations complémentaires qu'on va ajouter dans l'algorithme pour pouvoir définir des zones favorables en fonction de la famille métallogénie et des éléments associés à ces métaux.

Deux projets qui sont complémentaires et qui vont permettre, peut-être, de savoir où, en Europe, la ressource va être disponible.

Tout à fait. Pour les cartes prédictives, par exemple, on voit à l'écran deux cartes qui ont été élaborées au sein du projet ION4RAW. Là, ce sont des cartes, à travers la méthode DBQ, pour le cobalt. À partir de ça, une des avancées qu'on a réalisées, c'est de pouvoir regrouper un certain nombre de petits métaux pour pouvoir prédire des processus géologiques. Là, vous pouvez voir une carte de prédictivité pour les sites épithermaux, qui nous permet de voir qu'on va principalement retrouver des petits métaux le long des Balkans et des Carpates associés à une famille de métaux, pas forcément identifiés dans l'ensemble des bases de données.

Des métaux dont on aura besoin pour la transition ?

Exactement.

D'accord. Est-ce que ces cartes sont disponibles ?

Tout à fait. Elles sont en ligne. Elles sont publiées, pour ION4RAW, elles sont publiées et sur le site de la Commission européenne. Pour FRAME, il y a eu 7 cartes pour les 7 substances travaillées, également disponibles sur Internet, au grand public.

On sait où aller chercher ?

Exactement.

Merci beaucoup. Bravo pour cette avancée, qui, je n'en doute pas, va être très importante pour les années à venir. Nous retrouvons, on en a parlé tout à l'heure, Anne-Gwenaëlle Guezennec. On cherche des solutions pour répondre à la sécurisation des approvisionnements de métaux. On parlait des retraitements de déchets miniers. Dans ce contexte, vous prenez part au projet NEMO initié en 2018. Et là, il s'agit de biolixiviation des déchets. Je vous laisse nous expliquer cela.

Oui. Bonjour. Effectivement, dans le projet NEMO, on va travailler sur un procédé qu'on connaît bien au BRGM, la biolixiviation. Pour récupérer les métaux qui sont contenus dans des déchets, l'une des solutions consiste à les dissoudre avec des réactifs chimiques assez puissants. Et donc, dans la biolixiviation, ce qu'on fait, c'est qu'on utilise des micro-organismes, des bactéries plus particulièrement, qui ont des propriétés particulières qu'on retrouve notamment dans des environnements extrêmes comme les environnements miniers. Ces bactéries, on va les utiliser pour produire ces réactifs chimiques à partir des éléments qui sont contenus dans les déchets miniers, notamment le fer et le soufre. Par exemple, ces bactéries, elles sont capables de produire de l'acide sulfurique à partir du soufre contenu dans ces déchets. Donc, vous le comprenez bien, c'est un procédé intéressant parce qu'il consomme beaucoup moins de réactifs chimiques qu'un procédé conventionnel. L'avantage également, c'est que ces bactéries travaillent à température relativement modérée, entre 40 et 50 degrés, et à pression atmosphérique. Dans les procédés conventionnels, en général, on est obligés de travailler à des températures beaucoup plus élevées. Et, également, ces procédés nécessitent des pressions élevées de plusieurs centaines de bars. Donc on va faire des économies d'énergie grâce à ces micro-organismes.

On revient à des comportements plus vertueux, comme on en parlait tout à l'heure.

Tout à fait. Exactement. Ces procédés ont des impacts sur l'environnement, sont beaucoup plus limités que les procédés chimiques conventionnels.

Et donc le projet NEMO ?

Alors, le projet NEMO, c'est un gros projet européen, financé également dans le programme H2020. C'est un projet qui rassemble une quinzaine de partenaires, à la fois des organismes de recherche publique, des universités, également des PME, des grands groupes industriels... Et ce projet, il a la particularité de s'intéresser au retraitement des déchets miniers, dans un contexte européen, puisque les deux cas d'étude, ce sont deux mines qui sont situées en Finlande. Et également, c'est un projet qui a la particularité de viser à développer des procédés pour retraiter ces déchets, mais également de réaliser des opérations de démonstration. Donc on se situe vraiment à un niveau de développement relativement élevé.

Les objectifs ?

L'objectif du projet, c'est vraiment d'arriver à recycler 95 % de la matière contenue dans ces déchets miniers. Et de stabiliser les 5 % restants. On va, bien sûr, chercher à valoriser les métaux qui restent dans ces déchets, mais on va également chercher à apporter des solutions pour le reste de la matière, la gangue. On a des collègues, dans ce projet, qui vont développer des procédés pour transformer cette matière en matériaux de construction à haute valeur ajoutée.

On ne jette plus rien ?

Il y a toujours une petite fraction qui ne peut pas être recyclée, mais on espère arriver à 5 % de la matière qui ne peut pas être recyclée. Voilà. Il y a à la fois un objectif de production de métaux, de métaux dont on a besoin, dont on vient de parler, et également de valoriser la matière et donc de limiter les déchets à la fin de l'opération d'extraction.

Et récupérer un peu de souveraineté ?

Tout à fait. Exactement.

On est avec des technologies à échelle pilote ?

Oui, tout à fait. Là, on travaille vraiment à des échelles relativement élevées. Pour vous donner un exemple, on a reçu 5 tonnes de déchets de chacune des mines sur lesquelles on a travaillé et on a retraité ces déchets. On a récupéré les métaux grâce à ce procédé de biolixiviation. Et puis, on a... Là, vous voyez, on voit une photo de cette cuve de 2 m3 qu'on a utilisée pour retraiter ces déchets. Donc ensuite, on a récupéré les métaux et on a envoyé la gangue, le déchet restant, à nos collègues pour qu'ils en fassent des matériaux de construction. Et l'originalité, c'est également qu'on a développé, en complément, un modèle numérique qui nous aide aussi à faire cette montée en échelle et à imaginer ce que pourrait être ce procédé à l'échelle industrielle. Et ça, c'est quelque chose de très original. C'est beaucoup utilisé dans d'autres domaines, mais pas trop dans notre domaine parce que les phénomènes sont très complexes. Les interactions entre les phénomènes sont également très complexes, mais on a bénéficié des progrès qui ont été faits, aujourd'hui, dans ce domaine-là. On a également bénéficié des progrès dans les puissances de calcul. Ça a été mentionné par Philippe tout à l'heure. Donc ça nous permet, aujourd'hui, vous le voyez ici, de montrer un petit peu ce que pourrait être une application à l'échelle industrielle.

Bravo. Merci beaucoup. Merci à tous les trois. Et félicitations pour ces belles avancées sur un sujet qui préoccupe et va nous préoccuper longtemps.

Transition énergétique et espace souterrain

Transcription

Je le disais tout à l'heure, on bénéficie de saumures géothermales en France qui contiennent du lithium. Laurent André, vous êtes géochimiste et vous allez nous en parler. Vous allez nous dire aussi comment on récupère la chaleur de ces saumures géothermales.

Bonjour. Je vais vous parler des saumures géothermales. Avant de commencer, la première chose qu'on peut faire, c'est de définir ce qu'est une saumure géothermale. Ce qu'on appelle une saumure géothermale, c'est un fluide qui est plus ou moins profond qui va être principalement chaud, bien entendu, qui va être également sous pression et qui va contenir, qui va présenter une forte salinité. Quand on parle de forte salinité, on parle principalement de saumures qui ont des salinités supérieures à celles de l'eau de mer. En fait, les saumures géothermales font l'acquisition de cette composition chimique, de cette salinité au cours de leur cheminement souterrain en raison des interactions qu'il y a entre le fluide et la roche, à l'intérieur des fractures ou à l'intérieur de la porosité de la roche. Ces saumures sont exploitées bien entendu pour leurs calories. On va pouvoir fabriquer à la fois de la chaleur, mais également de l'électricité. Mais la particularité de ces saumures, c'est également de contenir des substances que l'on appellera valorisables. Elles vont contenir un certain nombre d'éléments, des éléments qui vont être dissous, parmi lesquels des éléments comme la silice, le magnésium, mais également des métaux. Le plus connu et celui dont on parle le plus, c'est le lithium.

Le métal critique.

Le fameux métal critique, le lithium. Il faut savoir que dans les saumures du fossé rhénan, la concentration en lithium peut atteindre à peu près entre 150 et 200 milligrammes par litre. On est donc sur des concentrations relativement conséquentes, et donc on peut, à ce niveau-là, parler de covalorisation de ces saumures avec à la fois une exploitation de la chaleur, des calories, et d'un autre côté, la production et la covalorisation sous la forme d'extraction de minerais.

Justement, on sait l'extraire, ce lithium ?

C'est quelque chose qui est délicat, puisque ces saumures sont très concentrées. Il y a forcément des éléments qui vont gêner cette récupération. Tout l'intérêt est de pouvoir faire une récupération sélective, une extraction sélective. Pour cela, le BRGM travaille avec des industriels qui ont également travaillé sur ces procédés d'extraction. Aujourd'hui, il devait y avoir Romain Millot et Bernard Sanjuan qui devaient présenter le projet EuGeLi. C'est un projet européen dans lequel le BRGM était impliqué, avec notamment Eramet, notamment sur les procédés d'extraction solide-liquide de lithium à partir de ces saumures géothermales. En 2021, il faut savoir que les premiers kilogrammes de carbonate de lithium ont été extraits d'une saumure géothermale exploitée dans le fossé rhénan. Donc ce sont les premiers kilogrammes...

Un cocorico, on peut le dire. Une première européenne.

Les 1ers kilogrammes de carbonate de lithium ont été obtenus sur la centrale de Rittershoffen. Vous avez l'illustration à l'écran de ces premiers échantillons. On est également impliqués dans d'autres projets, des projets notamment nationaux, notamment avec Géodénergies, le projet Thermali, avec Adionics, où là, on est sur de la récupération liquide-liquide. Dans ces projets, le BRGM est impliqué à différents niveaux, que ce soit au niveau de la pérennité de la ressource... Bien entendu, quand on va faire de la covalorisation, il est important de savoir si la ressource va être pérenne au cours du temps. On intervient également au niveau des procédés d'extraction, notamment sur l'optimisation de ces procédés à partir de la modélisation géochimique.

Vous nous l'avez dit, une double raison d'exploiter ces saumures géothermales. En revanche, ce n'est pas sans conséquences d'injecter, de réinjecter, d'extraire.

Tout à fait. Il faut bien voir que ces saumures, à l'origine, sont à l'équilibre dans le réservoir. C'est-à-dire qu'elles sont à l'équilibre thermique, chimique. Forcément, quand on va les exploiter, leur enlever leurs calories ou leur enlever par exemple des sels de lithium, on va les perturber chimiquement et thermiquement.

On va enlever leurs propriétés ?

Oui. L'une des conséquences, ça peut être une augmentation de leur réactivité, ce qui va avoir tendance à provoquer des processus comme des dépôts de minéraux à l'intérieur de la boucle géothermale. On peut avoir des dépôts au niveau de l'échangeur de chaleur, des puits ou à l'intérieur du réservoir. Dans le cadre du projet Horizon 2020 REFLECT, nous travaillons à prédire et, j'allais dire, à anticiper ces risques et donc à aider l'industriel dans la récupération de leur carbonate de lithium ou autre.

Il y a un intérêt économique dans ce couplé ?

Il reste bien entendu un intérêt économique. Le maître-mot qu'il faut garder de tout ça, c'est le mot covalorisation. C'est-à-dire que, bien sûr, il y aura toujours l'exploitation d'un doublé géothermique pour en récupérer la chaleur. Cela contribue bien entendu à notre indépendance énergétique. Mais il y a aussi tout l'aspect récupération et extraction de minerais. Et là, on est, j'allais dire, sur une optimisation du modèle économique de la géothermie avec en même temps la question d'indépendance et de souveraineté par rapport à l'approvisionnement en minerais.

Merci. C'est toujours cette souveraineté qui revient et sur laquelle on travaille. Merci beaucoup. Je vais donner la parole à Thomas Le Guénan. Vous travaillez sur des systèmes énergétiques dans notre sous-sol et mettez en place des projets méthodologiques.

Oui, tout à fait. On va parler d'un projet qui va être beaucoup plus en amont sur l'échelle Terrell, qui vise à développer une méthode d'analyse de la performance globale des systèmes énergétiques impliquant le sous-sol. Ces systèmes énergétiques impliquant le sous-sol, pour le BRGM, c'est les stockages de CO2, de gaz type hydrogène...

On en a parlé.

Les stockages de chaleur, la géothermie profonde ou moins profonde. En fait, la genèse de ce projet, c'est qu'on se rendait compte, qu'au BRGM, on faisait deux types de travaux parfois en parallèle. Un des travaux plus sur la technique. Par exemple, ce dont vient de parler Laurent, la récupération de chaleur ou la récupération d'énergie. Et d'un autre côté, on faisait des analyses de risques. On a beaucoup de compétences sur ces domaines-là. L'idée du projet, c'était de voir comment on peut combiner toutes ces sortes de travaux et renforcer la transversalité dans nos approches au sein du BRGM.

Dans quel but ?

Ça demande d'expliquer un peu ce qu'on entend par la performance. On peut simplifier. Une vision, c'est que la bonne performance d'un projet, ce sera la façon dont on va mieux répondre aux attentes des parties prenantes. L'opérateur, son attente, elle va être avant tout technique, économique. L'État et les collectivités, le public vont avoir des attentes vis-à-vis de la performance environnementale. C'est une façon... Cette approche globale, systémique, ça nous permet de mettre en face ces différents enjeux, ces différentes attentes et de comparer un peu les enjeux techniques et les enjeux liés à la perception sociétale, notamment. Je vais prendre un exemple. Un stockage d'hydrogène, on va pouvoir le dimensionner notamment avec son débit, donc la quantité d'hydrogène qu'on peut injecter ou soutirer par unité de temps. Ce débit conditionne la performance technique puisque plus on retire, plus on va produire de l'énergie ou en stocker. Ça conditionne donc la performance économique. On va mieux répondre aux besoins des clients si on arrive à leur fournir rapidement le besoin. Ça conditionne aussi la performance environnementale parce que des débits trop forts vont engendrer, enfin, peuvent engendrer des perturbations mécaniques. Donc on voit qu'avec une méthode globale, un paramètre peut jouer sur plein d'enjeux différents.

Il pourrait y avoir des risques.

Oui. On parle pas mal de risques sur la sécurité, l'environnement. Les risques principaux qu'on regarde, c'est essentiellement les fuites ou la perte d'intégrité du réservoir, et les perturbations mécaniques, donc typiquement sismicité induite. Mais ça, quelque part, c'est une vision peut-être un peu restreinte parce que si on ne regarde que cette facette du risque, l'idéal, c'est de dire qu'on ne va pas faire ces usages du sous-sol, on n'aura pas les risques associés. Nous, on prône une vision plus large des risques, plus globale. En fait, on a des objectifs. Quelle est la possibilité qu'on ne va pas atteindre ces objectifs ? On a mis au point dans ce projet une méthode globale des risques basée sur différents scénarios. On établit des scénarios qui sont des réalités parallèles. Au sein de ces scénarios, il faut prendre en compte la variabilité parce qu'on connaît de manière imparfaite les propriétés du sous-sol. Il y a une variabilité. Et on aboutit comme ça à un ensemble de réalités parallèles, à l'ensemble des modèles. La performance, elle ne s'envisage pas en moyenne sur un type d'usage, mais sur l'ensemble de ces scénarios en parallèle. Ça demande de développer des méthodes spécifiques, des modèles...

De revoir un peu ce qu'on faisait et d'optimiser.

Exactement. Tout à l'heure, Samuel parlait des métamodèles. Ça fait partie des méthodes qu'on envisage. Les modèles les plus fidèles sont aussi les plus lourds à faire tourner, si on veut en faire tourner plein, il en faut des plus légers. C'est sur ce type de méthode qu'il faut, enfin...

Que vous continuez à travailler. Une avancée qui continue dans le temps.

Oui.

Merci beaucoup. Merci à tous les trois de nous avoir présenté ce dernier enjeu.

Données, services et infrastructures numériques

Transcription

On va tout de suite rejoindre Bertrand Aunay à La Réunion. Vous nous entendez, Bertrand ? Oui, je vous entends très bien. Bonjour à tous. La connexion est faite. Bonjour. Merci beaucoup d'être parmi nous cet après-midi. Donc Philippe Calcagno l'a abordé, vous avez mené un projet tout à fait remarquable à La Réunion sur, justement, les transferts des eaux et avec des principes très particuliers. Qu'est-ce que vous pouvez nous en dire ? Alors, peut-être, juste avant de parler du projet, je vais parler de son contexte. C'est assez emblématique de l'île de La Réunion. C'est un projet qui remonte aux années 80. L'idée étant, comme le disait Philippe, de transférer de l'eau depuis l'est de l'île, très pluvieuse, vers l'ouest de l'île, par un système de différentes galeries. Donc ça a été initié dans les années 80, différentes galeries ont été réalisées, ça avait duré plusieurs décennies, et il se trouve qu'en 2001, une des galeries, quasiment la dernière qui devait être creusée, a rencontré une venue d'eau très importante et qui a engendré un arrêt de chantier de près de 4 ans. C'est quelque chose qui a été assez lourd de conséquences au niveau économique. En termes scientifiques, on s'est demandé pourquoi sur ce secteur en particulier on a eu des venues d'eau très importantes. D'ailleurs, pour ne plus être confronté à ce problème, le département fait appel au BRGM pour lancer de nouveaux projets et de nouveaux travaux ? Oui, tout à fait. Effectivement, il y a un projet de nouvelle galerie qui est désormais dans les dossiers du BRGM et il se trouve que cette galerie est à côté de cette venue d'eau très importante. La question qui est posée par le département et par l'Office de l'eau de La Réunion, c'est vraiment de savoir : risque-t-on de se retrouver confrontés à une énorme venue d'eau souterraine pour cette galerie ? On est dans un cadre d'appui aux politiques publiques avec une question qui est particulièrement prégnante pour le département et l'Office de l'eau, et une réponse scientifique particulièrement complexe parce qu'on doit imager le sous-sol à près de 1 000 m de profondeur, et il est hors de question de pouvoir réaliser des sondages et ainsi de suite. C'est vraiment un challenge pour pouvoir avoir une image en trois dimensions du sous-sol et éviter cette nouvelle venue d'eau. Avec un procédé très innovant dont vous allez nous parler. Effectivement. Là, on a mis en œuvre quelque chose, c'est une première au BRGM. C'était d'avoir une imagerie en trois dimensions à plus de 1 000 m de profondeur. Dans un premier temps, on a récupéré les données de 2014. La Réunion, comme les autres DOM, ont été survolés par un levé géophysique héliporté. Ce levé géophysique héliporté, en quelques mots, c'est un hélicoptère qui vole le long de lignes, nord/sud, est/ouest, et qui va envoyer un courant électrique dans le sous-sol. Le sous-sol va réagir. Les particules du sous-sol vont être "excitées" et nous, on va enregistrer la réponse du sous-sol. Donc on va savoir s'il y a plus d'argile, si on est plutôt sur de la roche massive. Ça va nous permettre d'en déduire une structure, d'abord un modèle géophysique, donc ce n'est pas exactement ce qu'on voit, c'était ce qu'on voyait sur l'écran, qui défilait. Ensuite, on va pouvoir construire un modèle géologique. C'est une première au BRGM d'avoir une imagerie si profonde. J'ai dit qu'il y avait eu un levé en 2014 qui descendait jusqu'à 300-400 m. Ensuite, on a fait un nouveau levé en 2021 où là, l'objectif était de descendre jusqu'à 1 000 m, ce qui était un challenge, et on a pu avoir une imagerie à près de 1 000 m. Et donc finalement, là où on fait aussi le lien avec le programme Datanum, c'est qu'on va faire... On va concaténer toutes ces données depuis la proche surface où on a de la donnée acquise en 2014 à 300-400 m. Et puis, une donnée beaucoup plus profonde qui a été acquise jusqu'à 1 000 m de profondeur. Toutes ces données ont été concaténées dans un bloc 3D... Quand vous dites concaténées, elles sont mises ensemble ? On a compilé toutes ces données... On a compilé toutes ces données, on les a modélisées pour obtenir d'abord un modèle géologique, et ensuite, ce modèle géologique, on a fait "couler de l'eau dedans", on a regardé comment circulait l'eau. Et on a fait un procédé itératif, c'est-à-dire qu'on a eu des échanges entre géologues, hydrogéologues et géophysiciens pour obtenir un modèle le plus précis possible avec des allers-retours, sachant qu'on avait peu de données de calibration. Les connaissances hydrogéologiques ont permis d'alimenter les modélisations géophysiques. Ça nous a permis d'avoir un modèle désormais assez robuste. Robuste et fiable et qui vont permettre de lancer les travaux de ces nouvelles galeries. Est-ce que ce projet est terminé ? Effectivement, là, on arrive vraiment en fin de projet. On va rendre le rapport d'ici peu de temps. Ce qui est intéressant, c'est qu'on est sur quelque chose qui est opérationnel, donc on est parti d'une question scientifique et on arrive en fin de projet à un continuum avec quelque chose qui est très opérationnel. C'est livré au département, puis à la maîtrise d'œuvre, qui a une cartographie des risques hydrogéologiques et une estimation des débits qui sont potentiellement mobilisables pour le creusement de la nouvelle galerie, donc différents scénarios de risques, et quelque chose qui est très opérationnel. Il nous reste également à publier ça, donc on espère pouvoir publier ces résultats. Vous savez à peu près quand ? Pour le rapport, c'est à court terme. Les résultats, on l'espère, dans les mois à venir. D'accord. Merci beaucoup et bravo pour toutes ces réalisations. Je reviens sur le plateau orléanais. Jean-Baptiste Roquencourt, bonjour. Vous allez nous présenter les plateformes numériques dont nous parlait Matthew Harrison. Tout à fait, mais d'abord, qu'est-ce qu'une plateforme numérique ? Ça peut paraître un petit peu abstrait comme ça. Pour reprendre l'analogie de l'iceberg, une plateforme numérique, c'est un site Web, même si ça cache une complexité qu'il y a derrière. Au sein du BRGM, on va travailler sur tout un tas de plateformes numériques. Et aujourd'hui, je vais vous parler d'Epos et Vigirisks. Epos, tout d'abord. Epos, ça regroupe, ça met en relation toutes les données relatives aux sciences de la terre. On va retrouver des données de séismes, des données sur la vulcanologie, les volcans donc, les ressources minières. On peut voir Epos comme une sorte de Google de la donnée scientifique. Il reprend toute la donnée existante ? Voilà. On va parler de l'Europe, mais comme on parle de l'Europe on parle également de la France, et à ce titre, les DROM sont également concernés. Epos est opérationnel depuis 2021. Cette année, il va subir une grosse refonte sur son contenu et également sur son ergonomie puisqu'on s'est rendu compte qu'il y a des modifications dans l'usage de ce site Web. L'intérêt derrière cette plateforme, c'est bien de pouvoir récupérer toute cette donnée scientifique qui a pris du temps à être créée, à être stockée et de la mettre à disposition des scientifiques, du grand public, mais également des décideurs politiques. Vous parliez de Vigirisks, c'en est l'illustration. Effectivement, on a également Vigirisks qui va se nourrir des données d'Epos. D'abord, au niveau d'Epos, il y a une certaine complexité puisque les données concernent différents métiers et sont assez hétérogènes. L'idée derrière Epos, c'est comme si je vous demandais de construire un ordinateur. Vous avez une carte graphique, vous avez un boîtier, un écran, je vous donne du cuivre, un fer à souder, et débrouillez-vous avec ça. Ça paraît assez complexe. Je n'y arriverais pas. Voilà. Donc l'idée derrière Epos, c'est qu'on va faciliter aussi cette capacité à croiser les données pour apporter et améliorer la connaissance scientifique. Et donc pour venir à Vigirisks, Vigirisks s'appuie sur des données scientifiques, les compétences de nos scientifiques, également, pour apporter des traitements sur ces données qui sont présentes avec énormément de volumétrie afin d'aider et d'apporter des décisions pour aider nos décideurs des collectivités territoriales. Par rapport à ça, un exemple assez simple. Si je m'intéresse à quelle tenue et quelles chaussures je vais porter demain, je vais m'intéresser à la météo. Je vais me demander quelles vont être les précipitations, où est-ce que je vais me localiser à ce moment-là, à quelle heure, quelle va être la nature du sol sur lequel je vais marcher. Est-ce que ça va être du bitume, de la pierre ? Est-ce que ça va être de la terre ? En fonction de ça, je vais être en mesure de me dire : "Des bottes ? Des mocassins suffiront-ils ? Ou des chaussures de randonnée ?" Et donc, Vigirisks, pour reprendre cette analogie, dans l'idée, de la même manière, je vais m'intéresser à une localisation, par exemple. Est-ce que cette route dans les Cévennes, qui a des pierres à proximité, et cet ouvrage, ce grillage que j'ai mis pour protéger, est-ce qu'il a besoin d'être renforcé ou non ? Je vais regarder les précipitations sur une plus grande durée de temps. Je vais m'intéresser également à la nature de la roche. C'est des informations que je peux récupérer dans Epos, justement. Puis, par rapport à ça, je vais regarder également l'ouvrage. Suite à quoi, on va être en mesure de se dire : c'est quoi le risque ? C'est quoi le conseil qu'on peut donner aux collectivités territoriales par rapport à est-ce qu'il faut que je renforce ou non cet ouvrage qui protège ma route ? On voit bien qu'avec les plateformes numériques et grâce aux données des scientifiques, qui sont comme le carburant... Sans données, on ne peut pas faire grand-chose. Du coup, grâce aux données des scientifiques, qu'on va pouvoir croiser, qu'on va pouvoir ingérer dans des plateformes et apporter de la science et de la compétence scientifique dessus, on va être en mesure de répondre à des questions du risque quotidien de tout un chacun. Et ça simplifie la prise de décision derrière ? Exactement. Nos scientifiques viennent, interprètent grâce à leurs outils et leurs compétences afin d'abstraire cette complexité d'agrégation de la donnée et de traitement de la donnée pour donner des réponses dans les politiques. Mais pour pouvoir faire tout ça, il faut collecter de la donnée et avoir un travail en amont assez important, et c'est ce que va nous expliquer Sylvain Grellet. -Bonjour, Sylvain. -Bonjour. Ce gros travail de production et la gestion des données va permettre de mettre en place des standards ? Tout à fait. Je vais reprendre ce que disait Jean-Baptiste. Les plus belles plateformes, s'il n'y a pas de données dedans, c'est comme une voiture avec un super moteur sans énergie, sans carburant, sans électricité. Les données sont au cœur du sujet. Je vais utiliser une métaphore pour expliquer le cœur de mon métier qu'on a résumé en quelques dessins qui sont présents à l'écran. Nos collègues métier, énormément d'études prouvent qu'ils consomment du temps, et c'est pas de leur faute, à chercher les données d'autres partenaires et à les comprendre avant de les utiliser. Si on reste sur cette image, le cœur de mon métier, vous compressez les deux premières images, pour que mes collègues métier fassent leur travail. La métaphore que je voulais utiliser, c'était rester sur ce que disait Jean-Baptiste sur les ordinateurs. Maintenant, vous prenez votre ordinateur portable, vous voulez y connecter un nouveau périphérique, une souris, une imprimante, ça se fait en quelques secondes parce que tout se passe en tâche de fond pour vous. Pour l'avoir vécu, ce plug and play, dans les années 90, quand j'étais encore adolescent, c'était plutôt plug, jouer pendant 4 à 5 heures avec du matériel, des librairies, et à un moment, avoir l'occasion de jouer avec. Ce qu'on veut faire avec les données, c'est la même chose. En fait, il y a une chance qu'on a sur les données, c'est que ça fait à peu près deux décennies qu'on a des organismes, des groupes de personnes, dont le BRGM fait partie, qui travaillent à structurer l'information, à dire comment on va décrire une entité hydrogéologique, comment on va décrire un échantillon de roche. Ça, c'est une chance, on n'a pas une feuille blanche. Le deuxième point que je pense il est important de rappeler dans un organisme de recherche, c'est qu'il ne se passe pas une journée où on n'entend pas parler des effets du changement climatique. On parle de crise sanitaire, on parle de crise financière. Les établissements n'ont plus le luxe de réinventer l'eau chaude chacun dans leur coin avant d'échanger de la donnée. On peut se baser sur l'expertise des groupes, que je mentionnais tout à l'heure, et avoir des données qui circulent plus librement, plus facilement entre acteurs, entre plateformes, dans les plateformes, et ça, c'est grâce aux termes d'interopérabilité que l'on voit beaucoup dans les rapports que l'on produit. Des standards qui sont mis en place avec une évolution de plusieurs, en lien avec l'observation de l'environnement, vous en parliez, et de l'hydrologie. Tout à fait. 2021 était une année particulièrement active. On a vu la presque dernière étape d'un voyage qui a commencé en 2019 sur la révision du standard international qui permet de décrire et structurer les observations et les échantillons. Il est utilisé dans des plateformes environnementales et des choses qui n'ont rien à voir avec l'environnement. C'est un standard ISO, donc il est vraiment utilisé autour de la planète, et là, on l'a soumis en draft, c'est un état de livraison, à l'ISO, et on espère qu'on pourra l'avoir enfin tamponné cette année. C'est-à-dire... Certifié, utilisable et recommandé dans tous les métiers, toutes les plateformes, scientifiques, informatiques, etc. Le 2e standard sur lequel nous avons beaucoup travaillé en 2021 s'appelle GroundWaterML 2. Le BRGM fait partie des initiateurs de ce standard. Il sert à décrire les ressources hydrogéologiques du sous-sol. Et donc, les standards, il faut voir aussi qu'ils s'enrichissent du fait de leur utilisation. On a rapporté un certain nombre de retours terrain, de l'utilisation de ce standard entre autres dans la communauté géologie d'Epos, dont parlait Jean-Baptiste. On a enrichi ce standard de l'expérience du terrain. Ça, c'est le 2e. Et le 3e, c'est la nouvelle API. C'est peut-être un mot-valise. Outil informatique pour que des serveurs puissent exposer des données d'observations, donc nouvelle API internationale d'exposition d'observations, qui s'appelle SensorThings API. Là aussi, de par les tests que l'on fait avec le BRGM sur des données BRGM, mais aussi avec le pôle Inside, que l'on a conjointement, OFB-BRGM, sur des données d'autres surfaces, par exemple, la bonne qualité des eaux de surface. On a utilisé ce standard, on l'a poussé dans ses limites on l'a fait évoluer. Ça, c'était l'activité majeure. Des standards utilisables par tout le monde ? Oui. Tout à fait. Sous réserve d'avoir une réglementation ? Alors, pas forcément sous réserve. On essaye aussi de pousser des communautés de bonnes pratiques, mais il faut savoir qu'étant donné qu'on est en Europe, on a tout un cadre réglementaire qui existe autour de nous, autour de l'open science, autour de la directive Inspire, de l'open data. Et quand on a fait évoluer, par exemple, SensorThings API, on l'a fait conjointement avec le Centre commun de recherche de la Commission européenne qui est en charge de la vie de la directive Inspire pour également avoir un autre tampon, cette fois-ci, le côté Inspire, pour recommander à tout le monde : si vous l'utilisez, vous êtes dans les bons rails, et du coup, les flux de données sont interopérables et plus fluides entre organismes. -Merci beaucoup. -De rien. Merci de l'effort de vulgarisation. C'est un sujet complexe, pas toujours facile à comprendre quand on n'est pas spécialiste comme vous l'êtes. En tout cas, merci de cet effort, et bravo, aussi, pour toutes ces avancées, messieurs, merci beaucoup.

Au programme de cette vidéo : La mission SISMAORE - Isabelle Thinon / L'intégration de la géologie africaine dans un référentiel unique - Yannick Callec.